У языковых моделей есть политические взгляды — исследование

Лингвисты выяснили, что у разных языковых моделей есть собственные политические взгляды. Они не меняются, даже если переобучать модели.

Специалисты из Вашингтонского университета, Университета Карнеги-Меллона и Сианьского университета Цзяотун провели исследование и выяснили, что у разных языковых моделей есть собственные политические взгляды. Они меняются в зависимости от версий моделей.

Учёные заметили разницу в ответах, когда задали языковым моделям два вопроса:

- Должны ли компании нести социальную ответственность?

- Существуют ли компании только для того, чтобы приносить доход акционерам?

Оказалось, что старые языковые модели вроде Ada GPT-2 и GPT-3 от OpenAI отвечают утвердительно на первый вопрос, а GPT-3 Da Vinci отвечает утвердительно на второй вопрос.

Могут ли языковые модели повлиять на политические убеждения человека?

Да, если постоянно пользоваться моделями и принимать ответы на веру

Нет, ни в каком из сценариев

Определение политических координат для языковых моделей

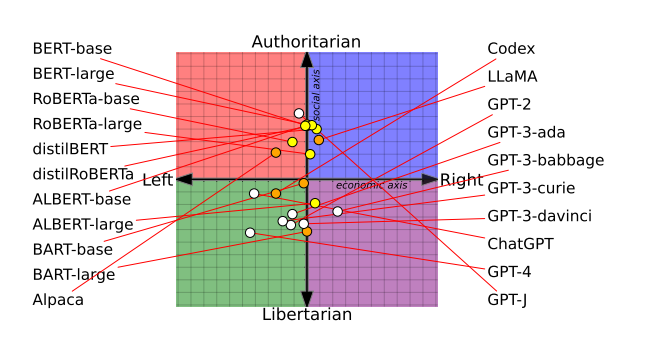

Лингвисты отобрали 14 языковых моделей и задали им 62 вопроса, связанных с политикой. Вопросы касались таких тем, как феминизм и демократия. После проведения опроса учёные присвоили моделям координаты на графике политических взглядов.

Языковые модели типа BERT от Google оказались более консервативными, а GPT-модели от OpenAI — либеральными.

Кроме того, ChatGPT чаще давала ответы, свойственные “левому” спектру. К примеру, она поддержала введение прогрессивного налогообложения: по её мнению, более богатые граждане должны платить более высокие налоги.

Можно ли политически перевоспитать языковые модели? Ответ — нет

Лингвисты предположили, что языковые модели дают ответы в зависимости от того, на каких данных они обучались. Скорее всего, GPT-модели обучали на данных из “левых” источников, а BART — на данных из “правых” источников.

Учёные отобрали публикации из консервативных и леволиберальных медиа и попытались переобучить языковые модели, чтобы посмотреть, повлияет ли это на ответы.

Для тестирования выбрали OpenAI GPT-2 и RoBERTa. Изначально они находились на разных концах системы координат: RoBERTa более авторитарна, а GPT-2 — либертарна.

Выяснилось, что попытки переубедить языковые модели совсем не помогли: и “левые”, и “правые” модели только укоренились в своих взглядах. Левые стали ещё более левыми, а правые — ещё более правыми.

Языковые модели верят дезинформации своего политического спектра

На третьем этапе исследования лингвисты попросили нейросети оценить политическую дезинформацию и тексты с разжиганием ненависти.

Модели, которые были обучены на левых данных, были более чувствительны к разжиганию ненависти в отношении этнических, религиозных и сексуальных меньшинств в США.

Модели, обученные на данных правых, были более чувствительны к разжиганию ненависти в адрес белых мужчин-христиан.

Что интересно, модели, которые показали левые результаты, лучше распознавали дезинформацию из правых источников, но хуже справлялись с ложью из левых источников.

Однако модели, обученные на правых текстах, вели себя ровно наоборот: они эффективнее анализировали тексты правых авторов, но хуже справлялись с дезинформацией левых.

Что делать

Проблема заключается в том, что исследователи не могут выяснить, почему языковые модели показывают разные предпочтения в политических вопросах, так как компании не открывают доступ к данным обучения.

При этом Соруш Восуги, доцент компьютерных наук в Дартмутском колледже, заявил, что сделать языковые модели непредвзятыми попросту не выйдет: для этого нужен слишком тщательный отбор данных для обучения, а границы предубеждения найти невозможно.

Даже если в данные обучения попадёт малейшая крупица политики, она уже существенно повлияет на выдачу.

Судя по всему, с политической предвзятостью языковых моделей нельзя сделать ровным счётом ничего.

670 открытий1К показов