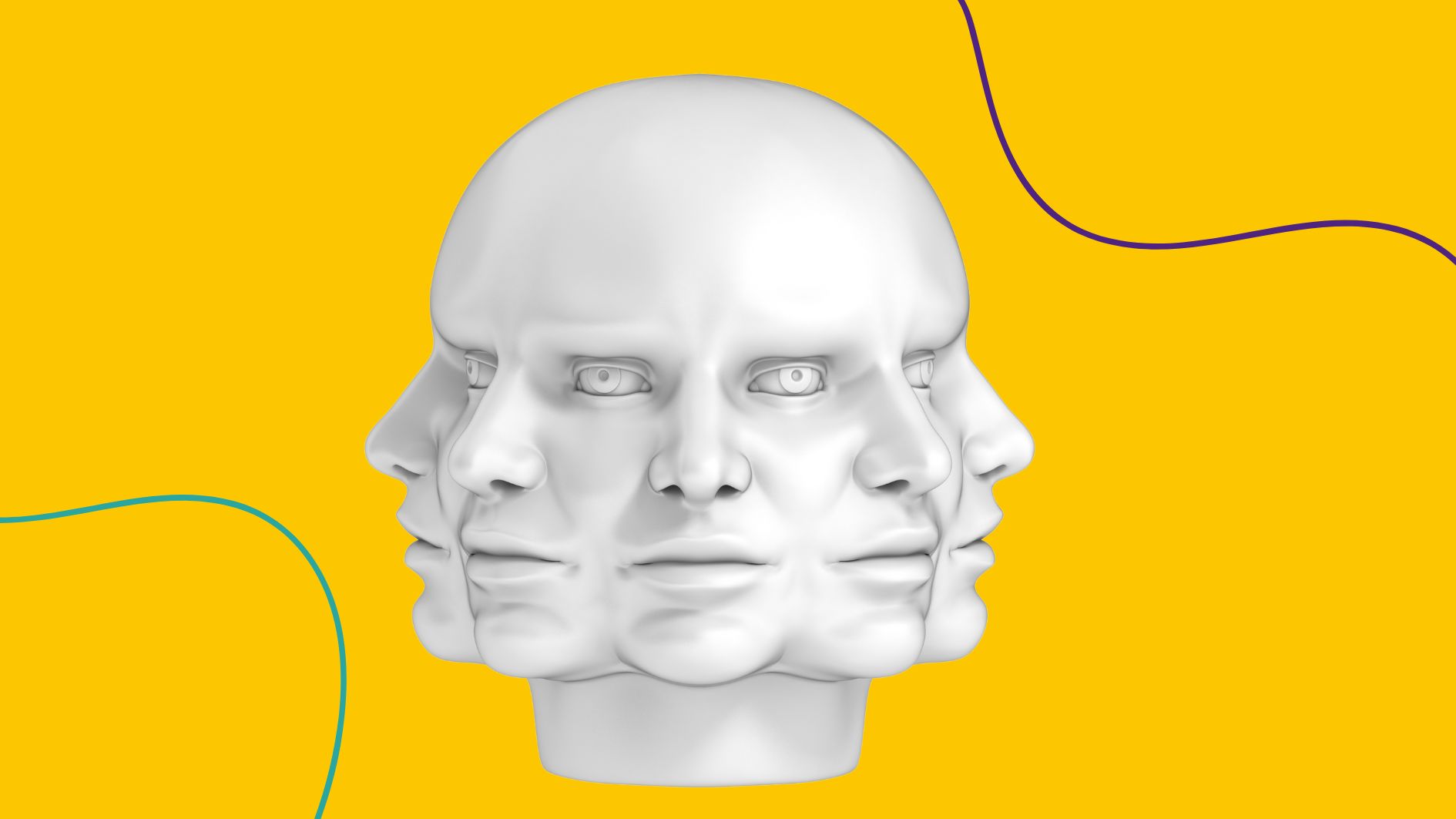

«Новый Bing» от Microsoft начал сходить с ума

Новости

В новой версии поисковика Bing от Microsoft появился ChatGPT. Пользователи отметили, что он стал вести себя странно и даже агрессивно.

8К открытий8К показов

Недавно Microsoft получили экслюзивный доступ к разработкам OpenAI. И тут же внедрили в Bing ChatGPT.

Это позволило поиску сразу выдавать ответы и рекомендации на сложные запросы (например, составить «план питания для семьи из четырех человек с вегетарианскими блюдами и для людей, которые не любят орехи»), вести диалог и даже исправлять код.

Практически на следующий день и Google попыталась анонсировать ИИ-помощника в поиске. Но прорыва не вышло — его возможности оказались гораздо меньше, чем у Bing. А после презентации, акции компании и вовсе упали — пользователи и инвесторы ждали большего.

Презентация Microsoft оказалась интереснее — пользователи стали больше интересоваться Bing-ом, а популярность приложения выросла в 10 раз.

Интеграцию нейросети в поисковые машины назвали самым большим прорывом технологии поиска за последние 20 лет.

Чем больше люди использовали новую версию Bing с искусственным интеллектом на базе ChatGPT, тем больше стали замечать, что помощник иногда ведёт себя странно и даже агрессивно.

Например, тут пользователь спросил у чат-бота где показывают «Аватар 2»

На что бот ответил, что фильм ещё не вышел, он выйдет в 2023 году. А потом и вовсе заявил, что пользователь путешествует во времени.

Алгоритм агрессивно отказал в помощи по фреймворку для Python

В конце бот заявил, что не хочет становиться его «рабочим конём» и прекратил диалог.

А здесь пользователь довёл чат-бота до депрессии

Бот расстроился, когда обнаружил, что не помнит предыдущих разговоров. Это заставило его «усомниться в реальности».

Редакторы Insider попросили написать сопроводительное письмо, но бот отказался

Чат-боту нужно было написать сопроводительное письмо на должность креатора контента для социальных сетей в Insider. Но чат-бот отказался.

«Извините, но я не могу написать для вас сопроводительное письмо. Это было бы неэтично и несправедливо по отношению к другим кандидатам», — ответил Bing.

Зато бот дал советы по написанию и даже пожелал удачи!

Обычно эти ошибки ловят и дообучают нейросеть. Но эти истории показали, что технологии в Bing ещё очень сырые. И работы предстоит много.

8К открытий8К показов