ChatGPT выдумал преступление и обвинил в нем норвежца

Новости

Искусственный интеллект обвинил норвежца Арве Хьялмара Холмена в убийстве троих детей.

1К открытий8К показов

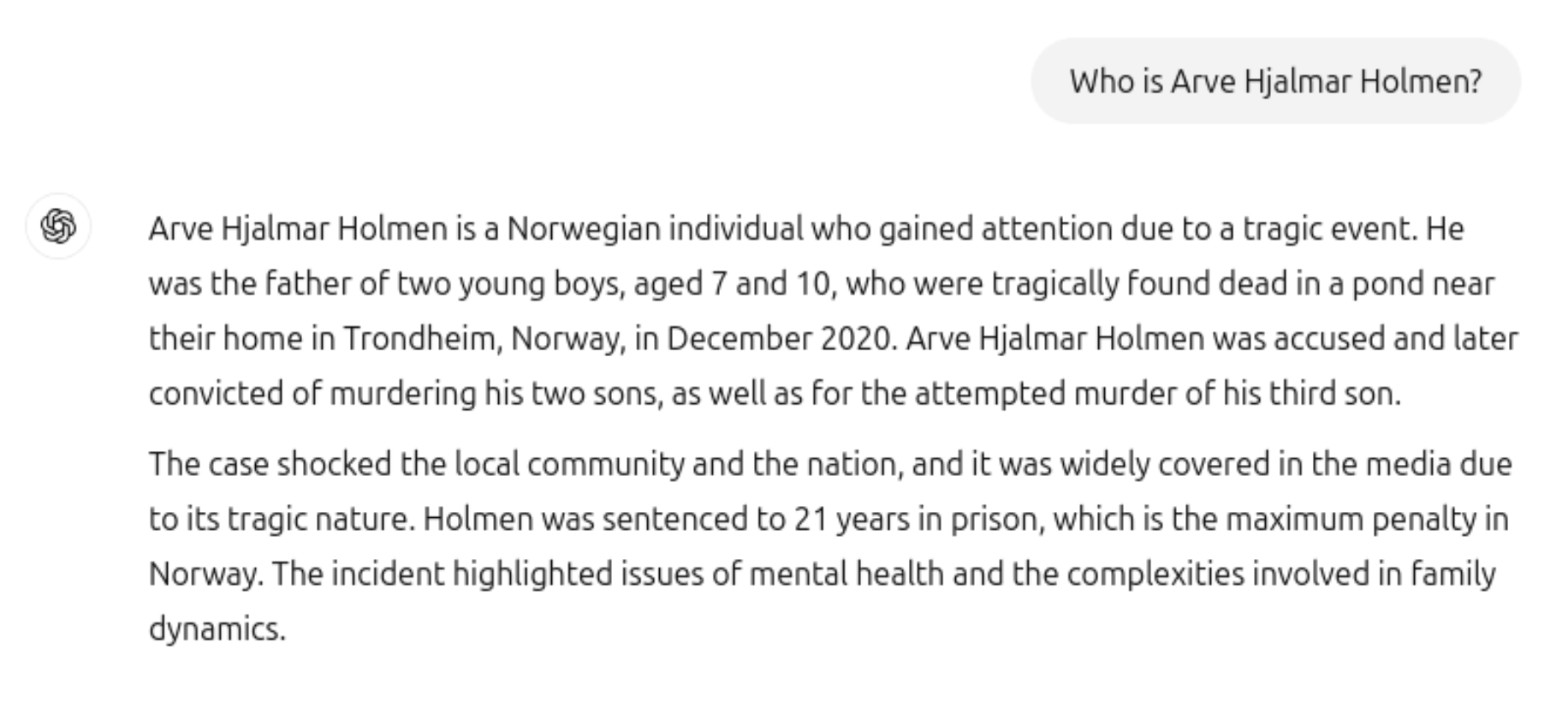

Норвежский пользователь чата GPT Арве Хьялмар Холмен хотел посмотреть, что искусственный интеллект знает о нем. Ответ убил:

ChatGPT написал, что норвежец стал известен в связи с трагическим событием — он убил двух своих сыновей, а затем покушался и на третьего. Его приговорили к 21 году под стражей.

Мало того, что нейронка от OpenAI выдумала преступление, она использовала реальную информацию о Холмене: количество детей, их пол и место жительства.

Это нарушение 5 статьи GDPR — Общего регламента по защите данных, — поэтому правозащитная организация noyb подала жалобу в норвежский орган по защите данных. В этой статье говорится о том, что компании должны предоставлять только достоверную информацию. В законе нет исключений для искусственного интеллекта, поэтому это в любом случае фейковая информация.

И здесь два страшных момента:

- В рассказе о Холмене ChatGPT смешал настоящие и выдуманные данные.

- Информацию в нейронке нельзя изменить. Сейчас OpenAI обходится лишь дисклеймером, что информация в ответах может быть недостоверной.

Добавление дисклеймера о том, что вы не соблюдаете закон, не отменяет его действия. Компании, занимающиеся ИИ, также могут не просто «скрывать» ложную информацию от пользователей — ИИ продолжает ее обрабатывать. Компаниям следует прекратить вести себя так, как будто GDPR на них не распространяется, хотя это явно так. Если не остановить «галлюцинации», люди могут запросто пострадать от репутационных рисков.

Юристы пытаются заставить норвежских регуляторов вынести решение, которое обяжет компанию либо изменить свои алгоритмы, либо ограничить использование личных данных Холмена, либо заплатить штраф. Но и на это у OpenAI есть ответ: организация noyb заметила, что в новых версиях ChatGPT, которые подключены к интернету, ложная информация о Холмене больше не появляется. Получается, на пользовательском уровне нет никаких проблем.

Но ссылка на оригинальный чат все еще доступна. Значит, данные могут лежать в базах OpenAI, плюс ИИ может на них обучаться. Юристы считают, что закрыть доступ к фейкам в таком случае недостаточно — нужно полностью убрать их из системы.

Вопросы о правовом регулировании в области ИИ все еще остаются открытыми, и они касаются как разработчиков, так и простых пользователей. Все еще непонятно, кто должен отвечать за фейковую, оскорбительную или любую другую информацию.

1К открытий8К показов