Google представила Learn2Compress, технологию оптимизации нейросетей для мобильных устройств

Новости Отредактировано

Learn2Compress является одной из ключевых технологий нового SDK для внедрения нейросетей в мобильные приложения ML Kit. Она обещает автоматическое эффективное сжатие и оптимизацию работы мобильных моделей машинного обучения без потерь в точности.

615 открытий623 показов

Google рассказала в своем блоге об одной из ключевых технологий нового SDK для разработки мобильных нейросетей ML Kit — Learn2Compress. Она позволяет эффективно использовать возможности фреймворка TensorFlow Lite и автоматически оптимизирует использование памяти и скорость работы модели машинного обучения.

Как она работает?

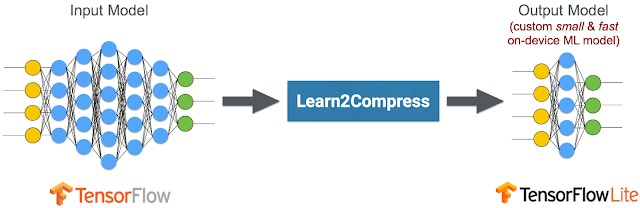

Для уменьшения размера модели и оптимизации ее работы технология использует как образец «взрослую» TensorFlow-модель и автоматически генерирует мобильную сеть на ее основе.

Для этого Learn2Compress использует следующие техники:

- сокращение операций, наименее важных для точности предсказаний;

- квантование, ускоряющее работу модели путем уменьшения количества битов, которыми она оперирует;

- совместное обучение и «дистилляция» — использование TensorFlow-модели в качестве учителя для нескольких мобильных нейросетей и выбор той, которая лучше подходит для нужд разработчика.

Сжимает хорошо?

По словам разработчиков, созданные с помощью Learn2Compress нейросети в разы превосходят созданные на других архитектурах по производительности и занимаемой памяти. Они приводят в пример социальную платформу для рыболовов Fishbrain, создатели которой уменьшили размер облачной модели классификации изображений с 80 до 5 мегабайт с сохранением такой же точности.

На момент написания новости Learn2Compress доступна ограниченному числу разработчиков. Для желающих открыта регистрация на предварительный доступ.

На прошедшей конференции для разработчиков Google I/O 2018 много внимания было уделено технологиям машинного обучения и компьютерного зрения. Обо всех анонсах можно прочитать в нашем материале.

615 открытий623 показов