Google AI разработала What-If Tool, инструмент для проверки объективности ИИ-моделей

Новости Отредактировано

Он не требует навыков написания кода.

1К открытий1К показов

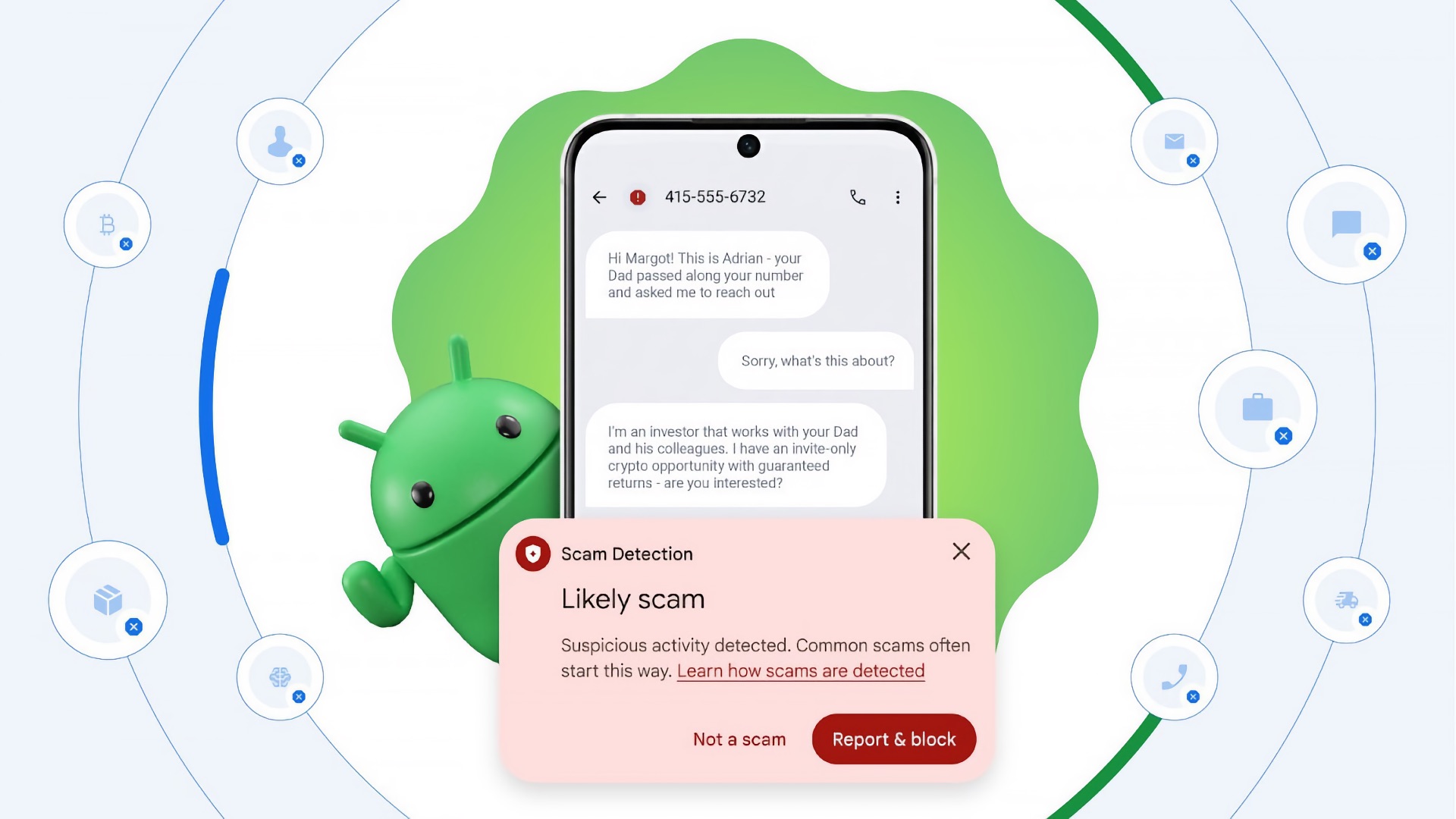

Команда PAIR (People + AI Reserach, часть Google AI) представила What-If Tool — новый инструмент для обнаружения предвзятости в моделях искусственного интеллекта. Он поставляется как часть веб-приложения TensorBoard. What-If Tool визуализирует влияние определенных данных на предсказание модели, при этом доступен для тех, кто не разбирается в программировании.

Что предлагает What-If Tool?

- Автоматически визуализировать набор данных с использованием Facets.

- Редактировать отдельные примеры из набора и отслеживать, как это отражается на результатах.

- Автоматически создавать графики частичных зависимостей, отражающие перемены в предсказании модели при изменении какого-либо одного свойства.

- Сравнивать наиболее похожие примеры из датасета, для которых модель дала разные предсказания.

Полный список возможностей разработчики указали на странице проекта.

Проверить работу инструмента можно на заранее обученных алгоритмах:

- модели многоклассовой классификации;

- модели классификации изображений;

- регрессионной модели.

Ученые и исследователи в области искусственного интеллекта обращают пристальное внимание на качество и разнообразие данных, используемых для тренировки алгоритмов. Иногда предубеждение попадает в результаты незаметно. Так нейросети, распознающие текст и речь, «подхватили» из датасетов стереотипы о гендерных ролях людей, после чего разработчикам пришлось искать специальное решение.

Последний пример влияния данных на результат продемонстрировали специалисты из MIT — это распознающая нейросеть Norman, которую обучали на картинках с тематикой смерти. В итоге она в пятнах из теста Роршаха видела сцены суицида и убийств.

1К открытий1К показов