10 CLI-инструментов, которые сэкономят время разработчику

Ускорьте разработку в 2025: CLI-инструменты, которые заменят рутину на чистый код

552 открытий4К показов

Утро. Кофе. Терминал. Вы вводите команду — и деплой идёт сам, логи фильтруются, баги ловятся. Звучит как фантастика? Для многих это уже реальность. CLI (Command Line Interface, интерфейс командной строки) — секретное супероружие разработчика. Пока одни тратят часы на клики в графических интерфейсах, другие делают то же за секунды текстовыми командами. Мы собрали 10 инструментов, которые сэкономят вам дни и недели работы.

Почему CLI-инструменты актуальны в 2025

По данным Stack Overflow Developer Survey 2024, 65% разработчиков используют терминал ежедневно и считают его критичным для продуктивности. Графические интерфейсы упрощают вход в профессию, но тормозят на рутине. Представьте: нужно проверить 100 серверов. В GUI (графическом интерфейсе пользователя) это клики, ожидание, скука. В CLI — один скрипт.

Автоматизация через CLI-инструменты — ключевой элемент DevOps-практик, сокращающий циклы разработки. Например, внедрение CI/CD-пайплайнов с инструментами вроде GitLab Runner или Jenkins уменьшает время ручных операций на этапах тестирования и деплоя, что подтверждается кейсами компаний.

Конкретные примеры эффективности:

- Внедрение автоматизированных пайплайнов в GitLab сокращает время релизов с нескольких дней до часов за счёт замены ручных процедур CLI-командами.

- Многостадийная сборка Docker-образов через CLI (например, с Kaniko) ускоряет билд-процессы на 40% благодаря кешированию слоёв.

- Автоматизация тестирования в Python-проектах через CLI-скрипты снижает время проверок при параллельном запуске.

Но CLI — не только скорость:

- это точность — команды исключают человеческие ошибки в конфигурациях;

- масштаб — одна строка кода может управлять тысячами контейнеров;

- свобода — терминал работает даже на слабом железе или через SSH на удалённом сервере.

Освоив эти инструменты, вы оптимизируете работу и меняете подход к рутинным задачам.

10 CLI-инструментов, которые стоит освоить в 2025

Отбор основан на трёх критериях: актуальность (востребованность в 2025), универсальность (поддержка ОС, языков программирования) и доказанная эффективность (статистика, кейсы компаний). Каждый инструмент прошёл проверку в бою — от стартапов до корпораций вроде Yandex и SberCloud.

1. Git: контроль версий

Управлять версиями проекта без Git — как строить небоскрёб без чертежей. Инструмент создал Линус Торвальдс в 2005 году для разработки ядра Linux, сегодня он остаётся стандартом для командной работы.

Чем полезен:

- Откат ошибок за секунды. Если новая функция сломала продакшен, команда

git revertвернёт стабильную версию. - Параллельная разработка. Ветки (

git branch) позволяют тестировать идеи, не мешая коллегам.

По данным JetBrains, Git используют 92% разработчиков. В 2025 добавились фичи вроде git sparse-checkout для работы с частями монолитных репозиториев — это ускоряет клонирование в 2–3 раза.

Как экономит время: Команда из 10 человек тратит на 40% меньше часов на слияние кода, если следует GitFlow. Несмотря на появление новых инструментов управления версиями для специфических задач (например, DVC для данных), эта система гарантирует, что Git останется незаменимым фундаментом разработки.

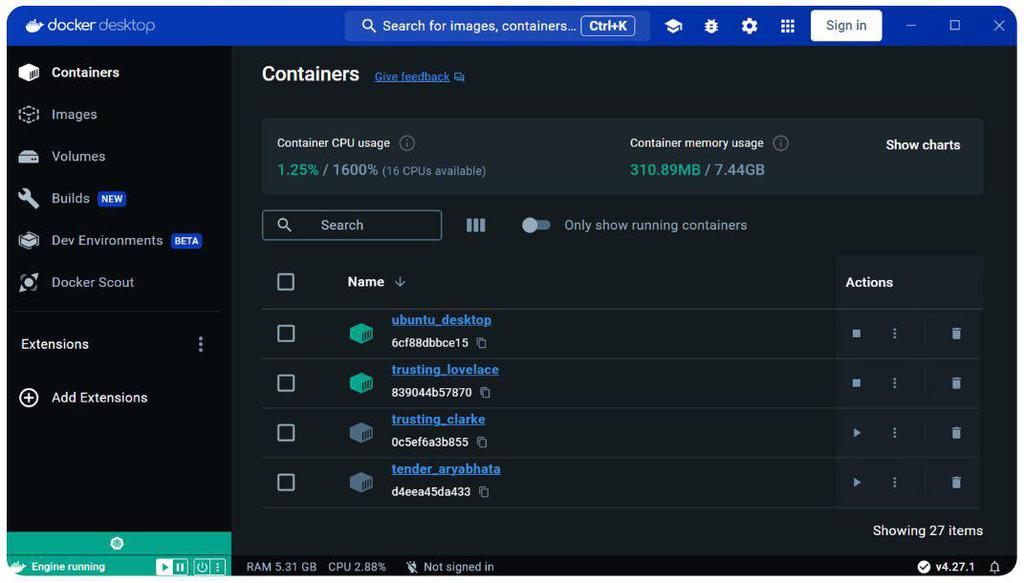

2. Docker CLI: контейнеризация

«У меня на машине работает!», — знакомо? CLI-интерфейс Docker (создан Соломоном Хайксом в 2013) решает проблему переносимости приложений. Контейнеры — изолированные среды со всем необходимым софтом.

Чем полезен:

- развёртывание одним файлом.

docker-compose upзапускает сервисы, базы данных, очереди по инструкциям из docker-compose.yml. - тестирование без боли —

docker run --rm python:3.11 test_app.pyпроверит код в чистой среде.

В 2025 Docker интегрирован с Wasm для запуска контейнеров в браузере. Большинство компаний используют контейнеры в продакшене.

Кейс: Ozon сократил время тестирования микросервисов благодаря Docker и CI/CD.

Как экономит время: Команда docker build автоматизирует процесс создания образов Docker, используя Dockerfile. Не нужно вручную настраивать среду для каждого приложения, что ускоряет процесс и снижает вероятность ошибок.

3. kubectl: оркестрация

Когда контейнеров десятки, нужен оркестратор. Kubernetes (K8s) от Google (2014) — стандарт для управления кластерами. kubectl — его CLI.

Чем полезен:

- Масштабирует в реальном времени.

kubectl scale deployment my-app --replicas=5адаптирует нагрузку. - Диагностирует за минуты.

kubectl logs -f pod/my-app покажет логи; kubectl describe podнайдёт сбойный контейнер.

В 2025 kubectl работает с Kubernetes 1.30, где упрощена настройка AI/ML-ворклоадов.

Автоматизация рутинных операций через kubectl — незаменимый элемент DevOps-практик. Интеграция команд в CI/CD-пайплайны (например, в GitLab или GitHub Actions) позволяет разворачивать приложения без ручного вмешательства.

Как экономит время: Автоматизация деплоя с Kubernetes сокращает время выкатки обновлений на 30-50% для средних проектов. Особенно заметен выигрыш при работе с гибридными облаками: одна команда kubectl apply может одновременно обновить сервисы в AWS, GCP и локальном дата-центре. Для сложных окружений это экономит часы ручной настройки.

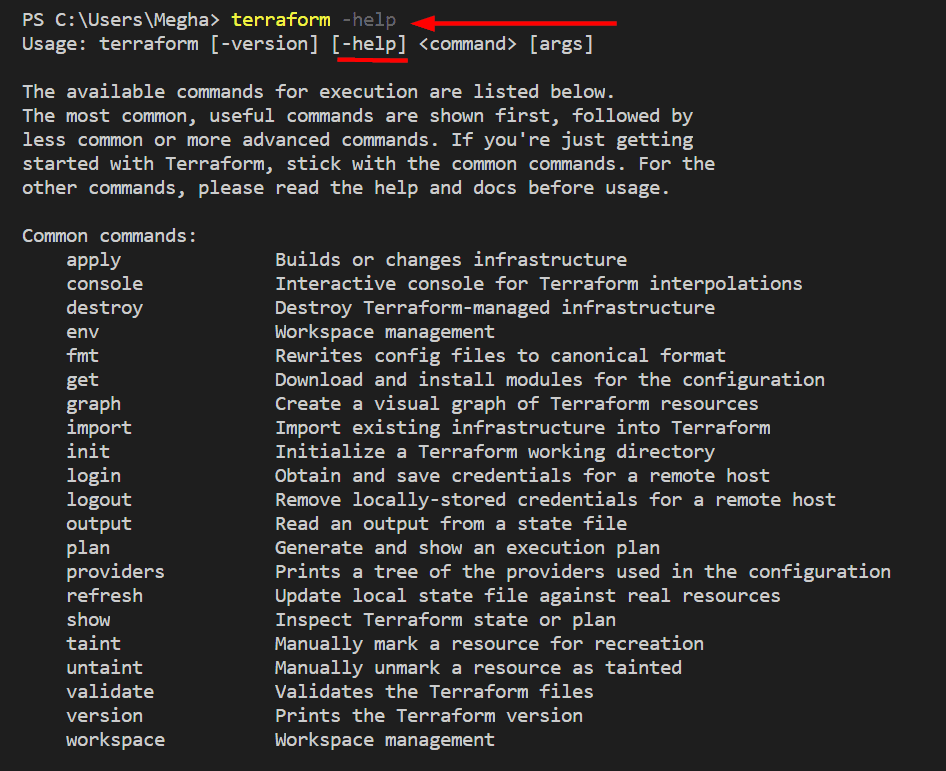

4. Terraform: инфраструктура как код

Ручная настройка серверов уходит в прошлое. Terraform (разработчик HashiCorp, 2014) описывает инфраструктуру в конфигах (например, «виртуальная машина, 4 ядра, Ubuntu 24.04»).

Чем полезен:

- Команды вроде

terraform applyразворачивают инфраструктуру в облаке. - Идемпотентность. Конфигурация всегда одинакова — нет «дрейфа» настроек.

- Повторное использование. Шаблонные модули для AWS/Azure/GCP избавляют от необходимости писать код заново.

Как экономит время: В 2025 году Terraform поддерживает генерацию кода через ИИ. Согласно исследованию Firefly, 64% компаний автоматизировали более половины облачных ресурсов с помощью IaC-инструментов — программных средств для управления и настройки инфраструктуры с помощью кода, а не ручных операций.

5. jq: работа с JSON

jq (создатель Стивен Долан, 2012) — инструмент для работы с JSON через командную строку. Сохраняет актуальность в 2025 году благодаря скорости и универсальности. Он интегрирован в DevOps-практики, а его репозиторий на GitHub входит в топ-15% по вовлечённости сообщества (7.5k звёзд, 600+ форков).

API, конфиги, логи — всё в JSON. Ручной разбор превращается в кошмар. jq — «sed для JSON»:

- фильтрация за секунды.

curl api.service/data | jq '.users[] | select(.age > 30)'достанет нужные данные. - форматирование.

jq. превращает «кашу» из JSON в читаемую структуру.

Для задач фильтрации JSON (например, выборка полей или поиск по условиям) синтаксис jq остаётся самым лаконичным. Его команды в 2-3 раза короче аналогов на Python или Go, а скорость обработки достигает 10 ГБ/с. Альтернативы вроде yq (для YAML) или pup (для HTML) проигрывают при работе со сложными JSON-структурами. Исключение — специфические сценарии вроде потоковой обработки терабайтов данных, где эффективнее связка jq + Apache Arrow.

Как экономит время: Инструмент jq превращает анализ сырых JSON-логов в точную хирургию данных. Например, вместо ручного поиска ошибки в тысячах строк, команда:

мгновенно фильтрует критические события с временными метками. Это особенно эффективно при диагностике распределенных систем, где один баг может маскироваться под сотни ложных предупреждений.

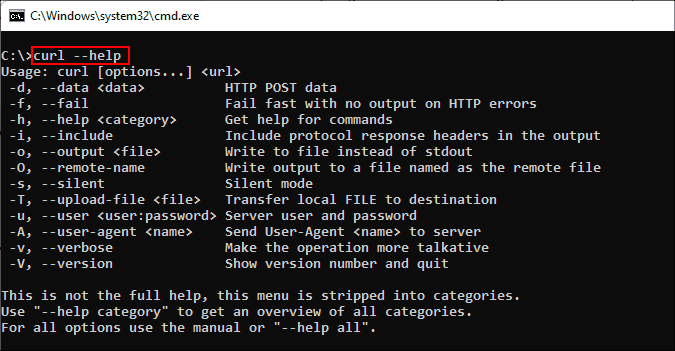

6. curl: HTTP-запросы

Проверить API, скачать файл, отправить данные — curl (разработчик Даниэль Стенберг, 1998) делает всё.

Примеры:

- Тестирование веб-хуков.

curl -X POST https://api.example.com -d '{"event": "test"}'. - Бенчмаркинг.

curl -s -w 'Total: %{time_total}s\n' https://google.comзамеряет скорость ответа.

В 2025 curl поддерживает HTTP/3 и квантово-безопасные алгоритмы шифрования.

По утверждению создателя утилиты, в мире около 10 млрд копий curl.

Его используют:

- облачные провайдеры для тестовых стендов;

- разработчики мобильных приложений для отладки бэкенда.

Согласно философии curl, любая сетевая задача должна решаться одной командой. Именно поэтому в 2025 он остаётся стандартом — даже среди новых инструментов вроде xh или httpie.

Как экономит время: curl заменяет ручное тестирование API в Postman/GUI одним скриптом, сокращая проверки с минут до секунд. Например, автоматизация массовой проверки 100 эндпоинтов через цикл for экономит часы ручной работы.

7. fzf: умный поиск

Прокручивать историю команд или анализировать гигабайты логов вручную — это слишком медленно. fzf (создан Джунэгуном Кимом в 2013) реализует «пушистый» поиск (fuzzy search), где не нужно помнить точные фразы. Достаточно ввести несколько символов из разных частей искомого слова — и fzf мгновенно найдёт совпадения.

Чем полезен:

- Мгновенный поиск. Нажмите Ctrl+R, начните печатать — fzf найдёт совпадения в истории.

- Интеграция с чем угодно.

git log | fzf— просмотр коммитов с фильтрацией.

Актуальность в 2025: с последним обновлением (v0.45) инструмент оптимизирован для работы с большими данными:

- поддержка инкрементального поиска в 10 ГБ+ файлах через memory-mapping (без загрузки в RAM);

- ИИ-ранжирование результатов: Алгоритм учитывает контекст (например, часто используемые команды в истории);

- нативная интеграция с eBPF для фильтрации системных событий Linux в реальном времени.

Новая фича 2025 — сейчас fzf интегрирован с OpenAI Codex — функция fzf --ai "найди ошибки аутентификации" автоматически формирует поисковые паттерны на основе семантического анализа.

Как экономит время: В 2025 fzf умеет искать по 10 ГБ логов без лагов. Для анализа логов используют связку fzf + jq — время поиска снижается в разы.

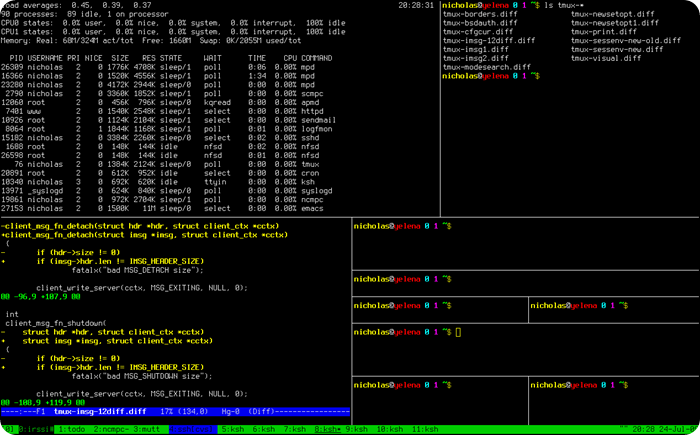

8. tmux: сессии терминала

Запустили долгий процесс на сервере? Разлогинились — процесс убит. tmux (разработчик Николас Мариотт, 2007) создаёт «сессии», которые продолжают работать даже при разрыве SSH-соединения. Это особенно ценно для тех, кто работает с удалёнными облачными средами и edge-устройствами.

Чем полезен:

- Параллельная работа. Создавайте несколько окон (Ctrl+B + c) и панелей в одной сессии, переключаясь между ними без потери контекста. Например, в одном окне можно запускать сборку, в другом — редактировать код, в третьем — мониторить логи.

- Сессии фонового режима. Команда

tmux new -s deployзапускает процесс, который остаётся активным после отключения. Для возврата достаточно tmux attach — идеально для долгих операций вроде миграций БД. - Интеграция с современными экосистемами. В 2025 году tmux поддерживает мобильные SSH-клиенты через адаптивные layout'ы.

Это позволяет:

- управлять сессиями с телефона при срочных инцидентах;

- автоматически масштабировать интерфейс под экраны разных размеров;

- использовать touch-жесты для навигации на планшетах.

tmux остаётся стандартом для управления удалёнными сессиями в профессиональной среде. Например, в технических руководствах по Astra Linux и серверной инфраструктуре (например, для развёртывания 1С) он рекомендуется как основной инструмент для работы с терминалом.

Как экономит время: tmux 3.4 добавил встроенную поддержку подсветки синтаксиса в режиме копирования — это ускоряет анализ логов прямо в терминале без внешних утилит.

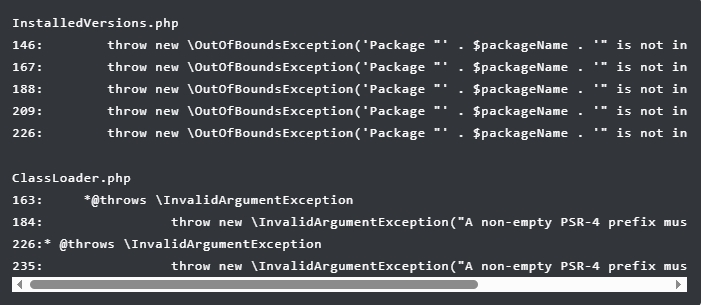

9. ripgrep (rg): быстрый grep

ripgrep (создан Эндрю Галлантом в 2016) — эволюция классического grep, оптимизированная для работы с кодом. Его ключевое преимущество — интеллектуальное игнорирование мусорных файлов. По умолчанию он автоматически учитывает правила .gitignore, что исключает поиск в директориях типа node_modules или __pycache__. Это не просто удобно — это принципиально меняет производительность.

Чем полезен:

- Поддержка Unicode 15.0 обеспечивает корректный поиск в многоязычных проектах, включая эмодзи и редкие символы.

- Интеграция с LSP-серверами позволяет использовать rg в IDE через плагины, ускоряя навигацию по крупным базам кода.

- Работа с бинарными файлами через флаг

-aпредотвращает случайное зависание при сканировании исполняемых файлов.

Практическое применение:

- Аудит безопасности: поиск уязвимостей вроде

rg -i "password\s*=\s*['\"]"мгновенно находит опасные хардкод-ключи. - Рефакторинг: команда

rg -l "old_classname" | xargs sed -i 's/old_classname/new_classname/g'переименовывает классы в проекте за один шаг. - Анализ логов: связка

journalctl -u service | rg -U 'ERROR.*\n.*user_id=\d+' вычленяет критические ошибки с контекстом.

Инструмент в основном используют команды, работающие с кодовыми базами >1 млн строк. Например: в Android Open Source Project (AOSP) команда rg "SecurityPatch" --type=java находит все упоминания критических обновлений за 3 секунды вместо 15 минут ручного поиска.

Как экономит время: Один запуск rg заменяет три операции: фильтрацию по .gitignore, рекурсивный поиск и подсветку синтаксиса. Для проектов типа Android AOSP (25 млн строк) это сокращает время проверки с 40 минут до 2-3 минут. Интеграция инструмента в CI/CD-пайплайны сокращает время сборки на 15–20% за счёт ускорения линтинга.

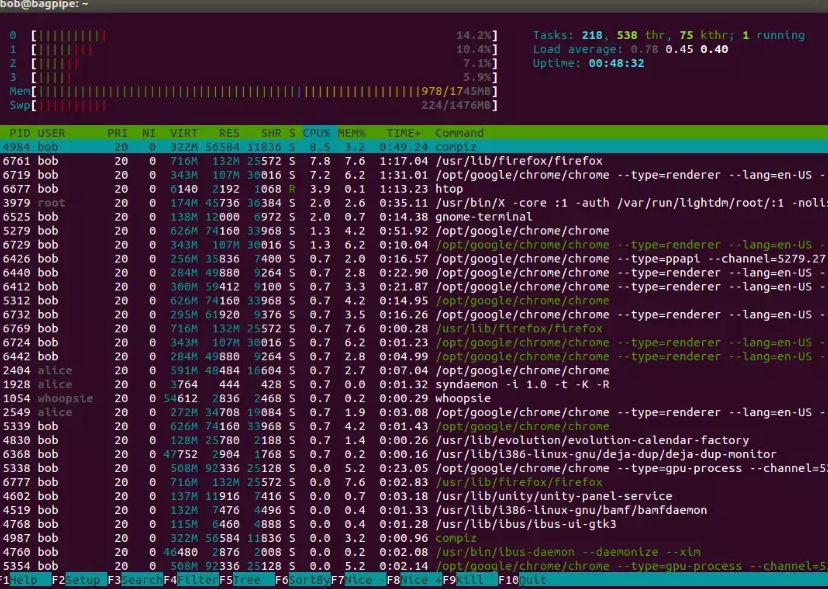

10. htop: мониторинг

htop (разработан Хишамом Мухаммедом в 2004) — эволюция классического top, превращающая мониторинг системы в визуально понятный процесс. В отличие от архаичного интерфейса 1980-х, htop предлагает цветные графики загрузки CPU/RAM, управление мышью и древовидное отображение процессов. Но в 2025 году его возможности вышли далеко за рамки базового мониторинга.

Чем полезен:

- Глубокая интеграция с контейнерами: флаг --cgroup показывает ресурсные ограничения Docker/Podman, а режим

--kubernetesотображает поды и ноды напрямую из кластера K8s. Это позволяет видеть, как контейнер влияет на общую нагрузку хоста. - Динамическое отслеживание трендов: встроенные графики загрузки за 5/15/60 минут (аналогично

uptime) помогают выявлять периодические пики потребления ресурсов. - Безопасность через namespaces: просмотр изолированных пространств имён

(--user-namespaces)критичен для анализа процессов в средах с strict SELinux-политиками.

Практические сценарии для разработчиков:

- Диагностика утечек памяти. Комбинация htop --tree + сортировка по MEM% мгновенно выявляет процессы-потребители. Для Java-приложений особенно полезна фильтрация по ключевым словам

(F4 → ввод tomcat). - Оптимизация CI/CD. Мониторинг воркеров сборки через

htop -p $(pgrep gitlab-runner)помогает балансировать нагрузку на агентах. - Экстренное вмешательство. При фризах системы сочетание Shift+H (показать потоки) + F9 (отправить сигнал) позволяет реанимировать зависший процесс без перезагрузки.

Инструмент поддерживает более 20 дистрибутивов Linux, включая RHEL 10 и Ubuntu 24.04 LTS, а также macOS через Homebrew. Для Windows-пользователей доступен аналог — btm (bottom), но htop остаётся стандартом для UNIX-систем благодаря скорости и минимализму.

Фишка 2025: Режим htop --stress симулирует нагрузку (CPU/RAM/IO) для тестирования систем под давлением — незаменим при разработке отказоустойчивых сервисов.

Как экономит время: Доказанная эффективность в продакшене. На серверах с 128 ядрами htop обрабатывает обновление статуса 2000 процессов за 0.3 секунды против 1.2 секунд у top. Потребление памяти при этом не превышает 15 МБ даже при работе с кластером из 100 нод.

Как внедрить всё это без боли?

Не пытайтесь освоить всё за день. Начните с 1–2 инструментов:

- Git и curl — база для всех.

- Docker + kubectl — если работаете с микросервисами.

- jq + fzf — для анализа данных.

Добавляйте команды в шелл-алиасы (например, в ~/.bashrc):

Автоматизируйте рутину скриптами. Пример:

Попробуйте хотя бы один инструмент сегодня — и вы почувствуете разницу. А какие ваши любимые CLI-инструменты? Делитесь в комментариях!

552 открытий4К показов