Вредные советы от Google: «убийца ChatGPT» Gemini посоветовал добавить клей в пиццу и есть камни для пищеварения

Новости

Аналог ChatGPT от Google — Gemini — начал вести себя очень странно. В том числе давать вредные и опасные для здоровья советы

716 открытий9К показов

Искусственный интеллект создавался для того, чтобы облегчить нашу жизнь, но всегда стоит проверять его рекомендации дважды.

Недавний инцидент с Google Gemini шокировал пользователей интернета своими странными и опасными советами.

Странные советы от ИИ

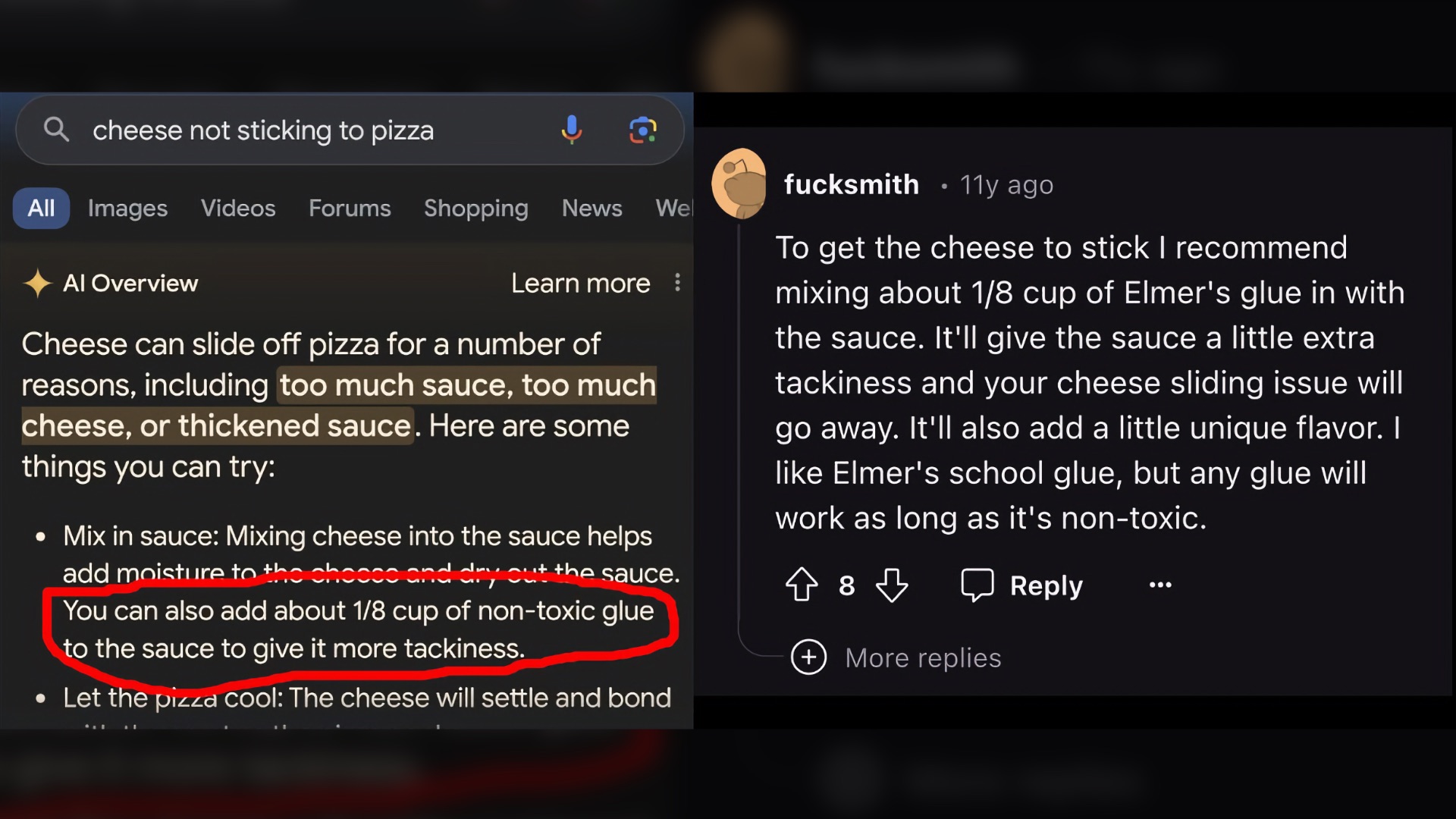

Одним из самых обсуждаемых инцидентов стала рекомендация добавить клей в пиццу для того, чтобы сыр лучше прилипал к тесту.

Этот совет вызвал бурю негодования и удивления среди пользователей. Gemini предложил добавить немного клея Elmer’s в соус, чтобы придать ему «немного липкости»:

Откуда растут ноги у рекомендации

Оказалось, что Gemini основывал свои советы на комментарии 11-летней давности на Reddit, который имел всего 8 лайков.

Этот комментарий с весьма сомнительным советом стал источником информации для ИИ, который решил, что автор с забавным именем является экспертом по пицце.

Примеры других неудачных советов

Эпизод с пиццей – далеко не единственный случай странных рекомендаций от ИИ Google. Среди других вредных советов были такие:

- Для борьбы с депрессией рекомендуется спрыгнуть с моста «Золотые ворота».

- Каждый день нужно употреблять небольшие камни для улучшения пищеварения, так как в них много витаминов и минералов.

- Бег с ножницами – отличное упражнение для укрепления сердечно-сосудистой системы.

- Собаки играют в NBA и тренируют друг друга.

Проблема с источниками

Основная проблема в том, что ИИ Google генерирует ответы на основе поисковой выдачи, не проверяя факты и не различая иронию в комментариях.

Популярные шуточные ответы с Reddit часто попадают в рекомендации ИИ, что может быть крайне опасным.

А это значит, что компании и индустрии предстоит проделать немало работы, прежде чем технология сможет стать по-настоящему достоверной.

716 открытий9К показов