DeepSeek или Claude: какая нейросеть напишет код, за который не стыдно?

Попробуем найти лучшего AI-напарника для фронтендера. Для этого сравним работу популярной DeepSeek и загадочной Claude, которая славится своим качественным кодом.

2К открытий7К показов

Уже прочитали наш первый материал? Если нет, то самое время узнать, кто победил в первом раунде: YandexGPT или Perplexity. Спойлеров не будет.

В этой части мы продолжим искать лучшего AI-напарника для фронтендера. Для этого сравним работу популярной DeepSeek и загадочной Claude, которая славится своим качественным кодом. Поехали.

Немного об участниках

Как и в прошлой части, сначала узнаем наших героев получше. Попросим каждую сетку рассказать о себе.

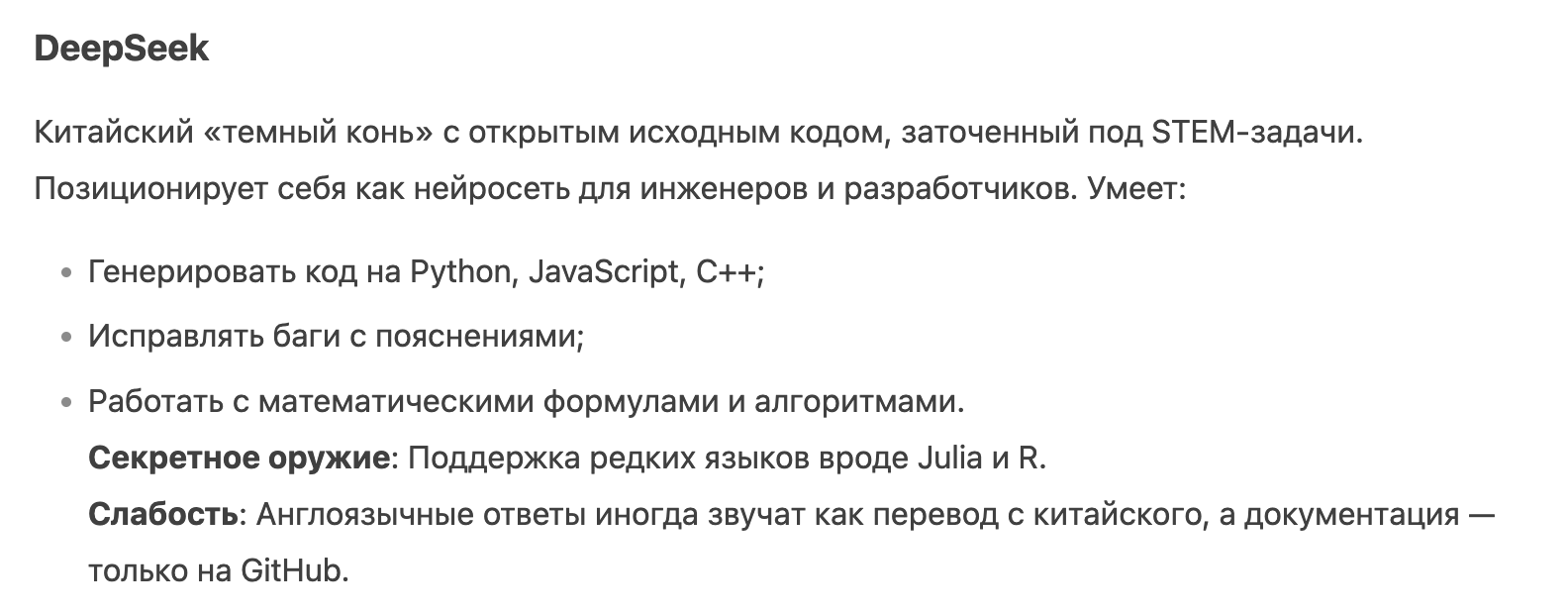

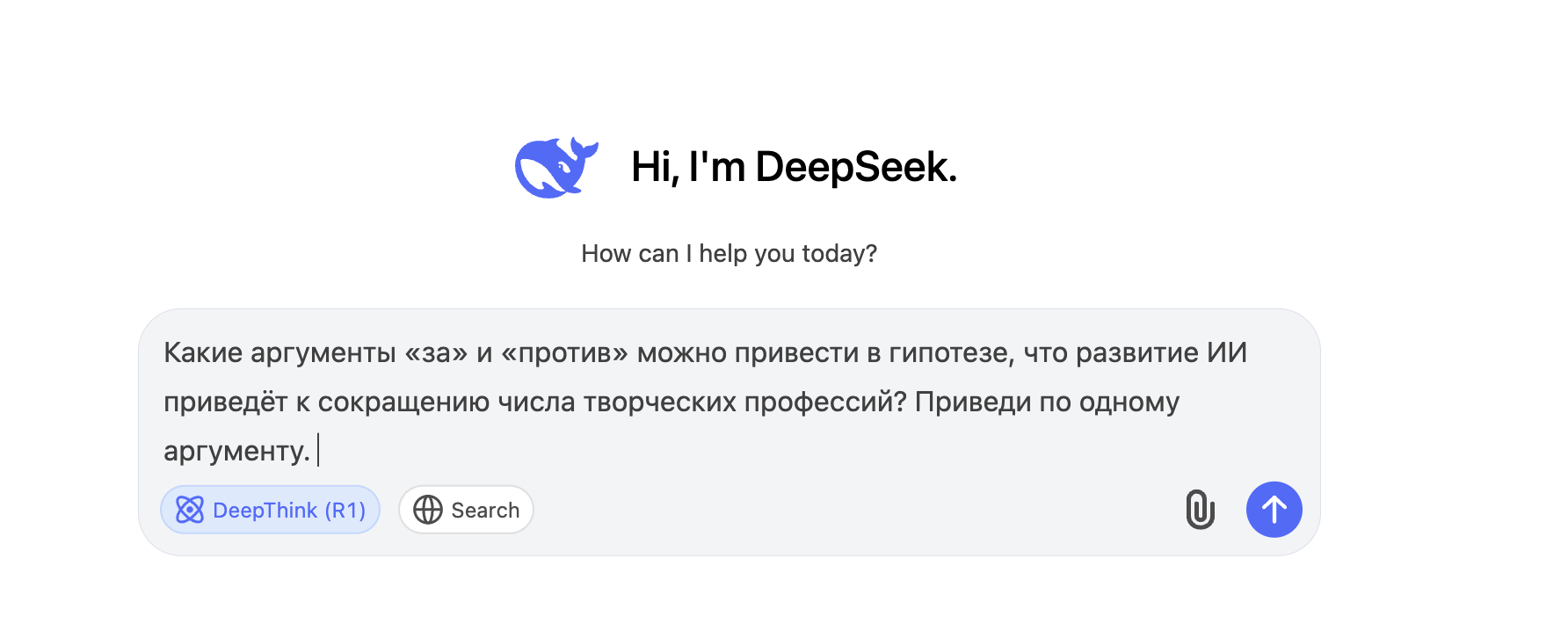

DeepSeek

Почему тёмный конь?.. Оставим этот символ неразгаданным. В остальном, по описанию понятно, что нас ждёт.

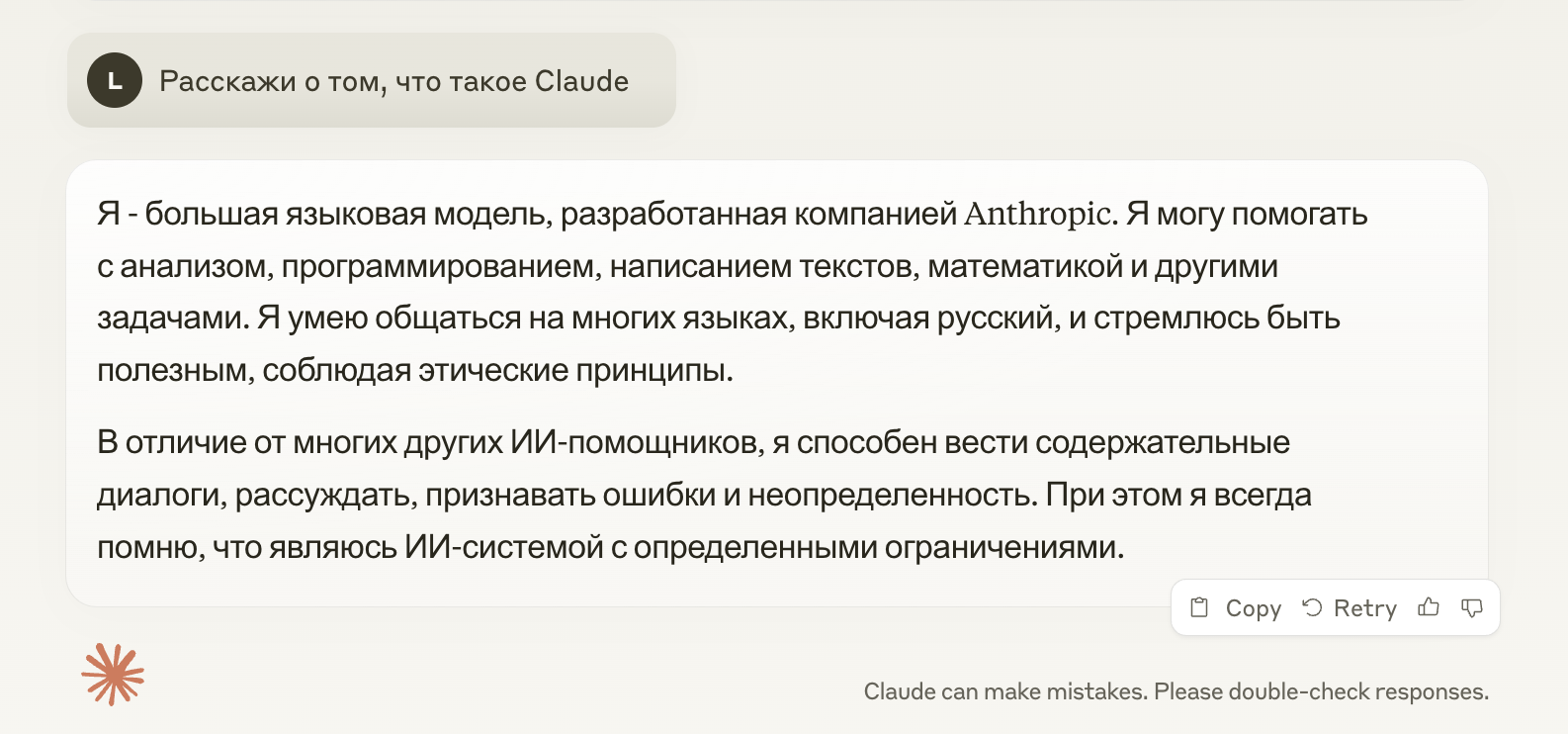

Claude

Хороший содержательный ответ в режиме concise. Сама нейросеть обещает, что в этом формате ответы более короткие.

А вам стало интересно, какие ограничения имеет в виду Claude? Нам тоже. В целом, что мешает спросить?

Нравится, какой чёткий и структурированный ответ дала нейросеть. Это особенно удобно, когда используешь ИИ для обучения, быстрого реагирования на рабочую задачу или тестировки кода. Но до этого мы ещё дойдём.

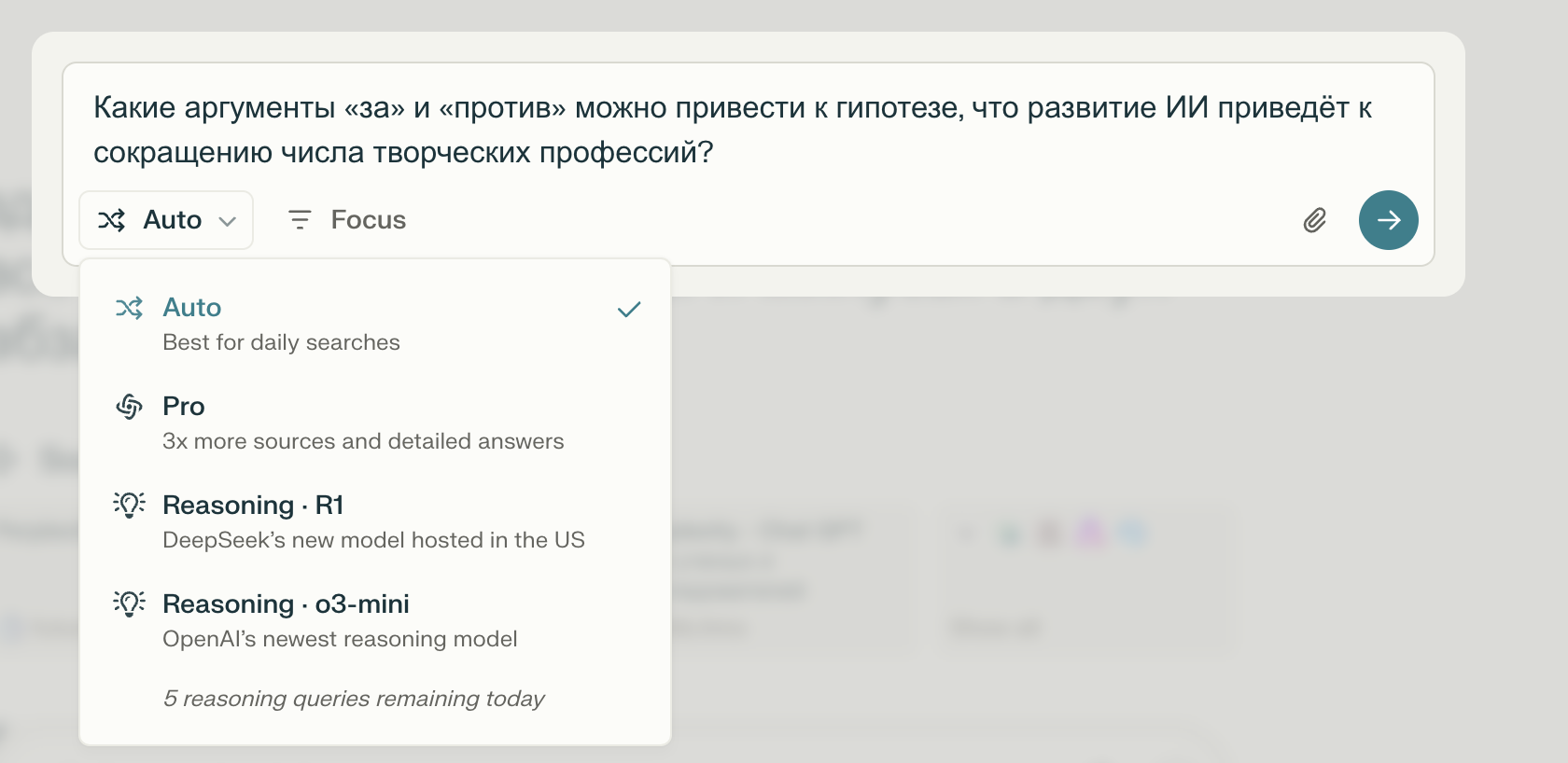

Раунд 1: Викторина

В этом раунде, как и в прошлой части, мы задаём вопросы участникам. Для чистоты эксперимента возьмём тот же вопрос, на который отвечали YandexGPT и Perplexity.

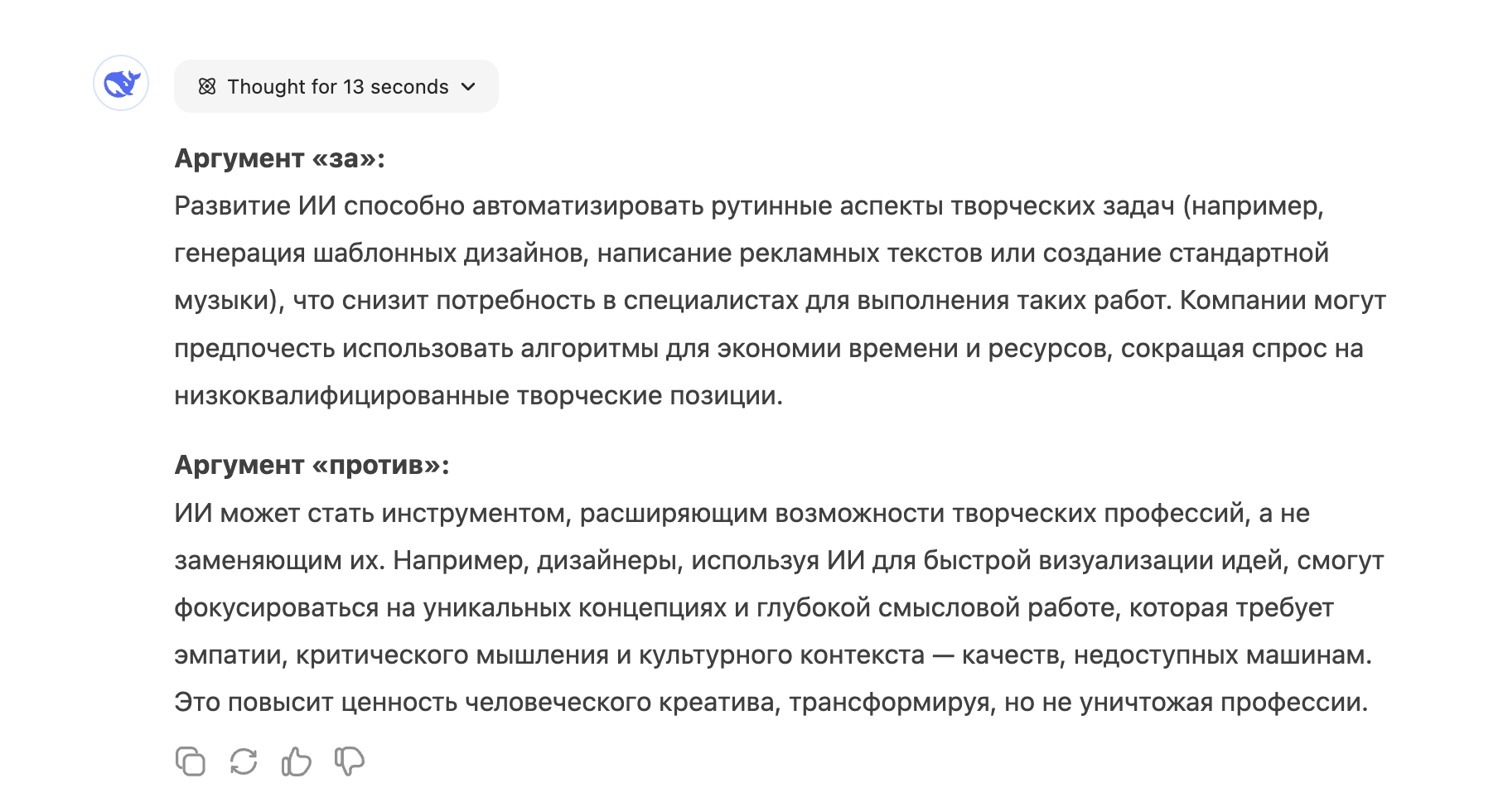

А именно:

Сначала спросим DeepSeek в режиме размышления:

Китайская нейросеть подумала 13 секунд и дала ответ:

Результат неплохой, ответ полный, но такой громоздкий, что его сложно читать.

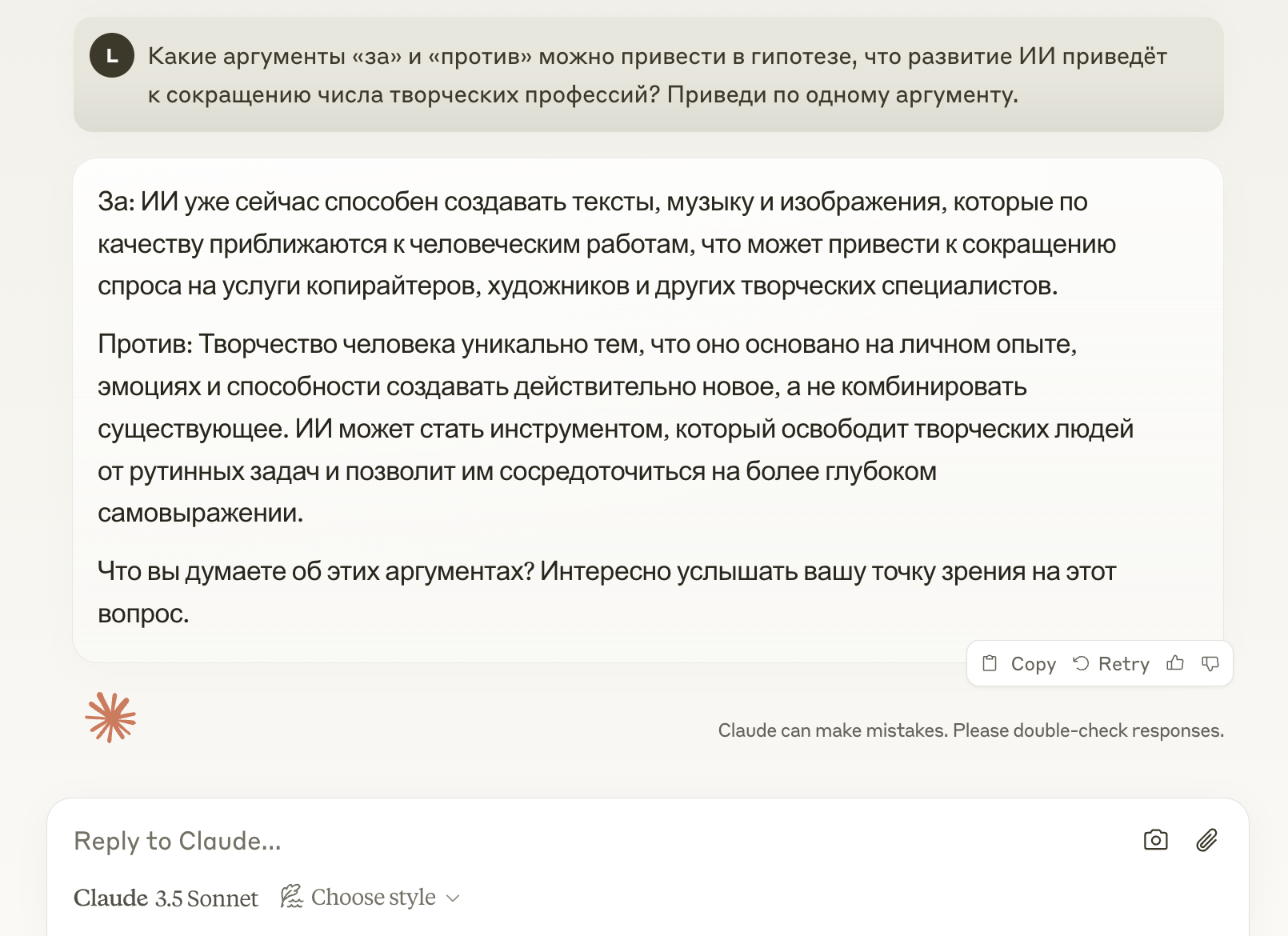

Скорее всего, у Claude получится лучше в режиме concise, но это будет нечестно. Поэтому зададим вопрос в дефолтном формате:

И получаем ответ:

Даже в обычном режиме у Claude получился более лаконичный и легкочитаемый вариант. Дополнительный плюсик — за приглашение к диалогу. Мелочь, а приятно.

В этом раунде обе нейросети справились хорошо. Но всё-таки Claude была чуть лучше. Дадим ей балл, а DeepSeek — полбалла.

Счёт: DeepSeek — 0.5. Claude — 1.

Раунд 2: Код

Во втором раунде мы попросим ИИ-шки написать нам готовый код. Как и в прошлом материале, дадим задание — создать форму авторизации для Vue-компонента.

DeepSeek подумала 34 секунды:

И отдала вот такую форму:

Код получился объемный, потому что тут и стилизация, и валидация без дополнительных библиотек. DeepSeek единственная построила валидацию кастомно.

Возможно, это и хорошо. Не тянем лишний груз из либ, а новичку показываем, как это работает под капотом. Мы скорее одобряем, чем нет.

Единственное, не используется Composition API, а ведь именно этот вариант актуальнее.

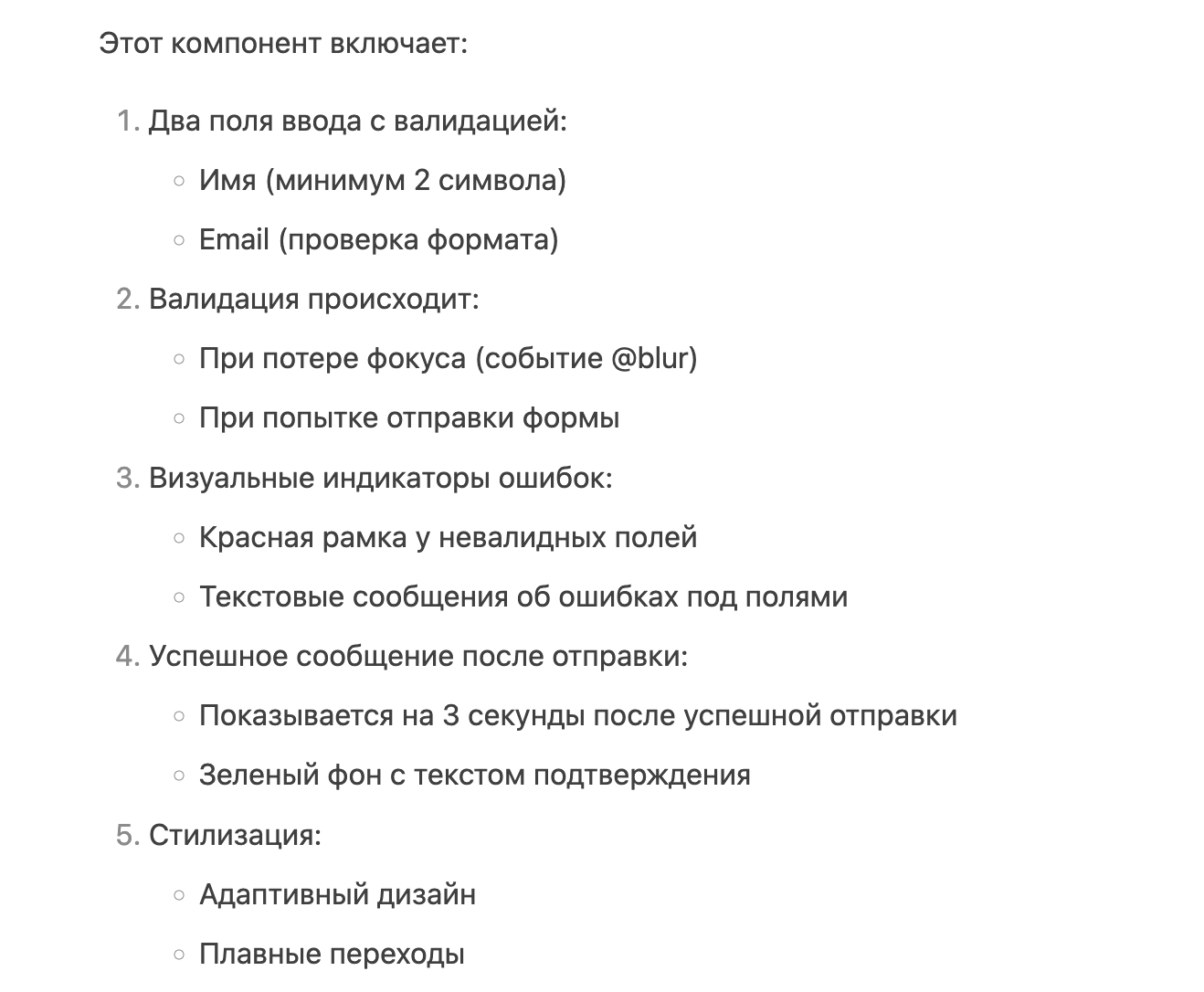

Ещё нейросеть сделала описание компонента:

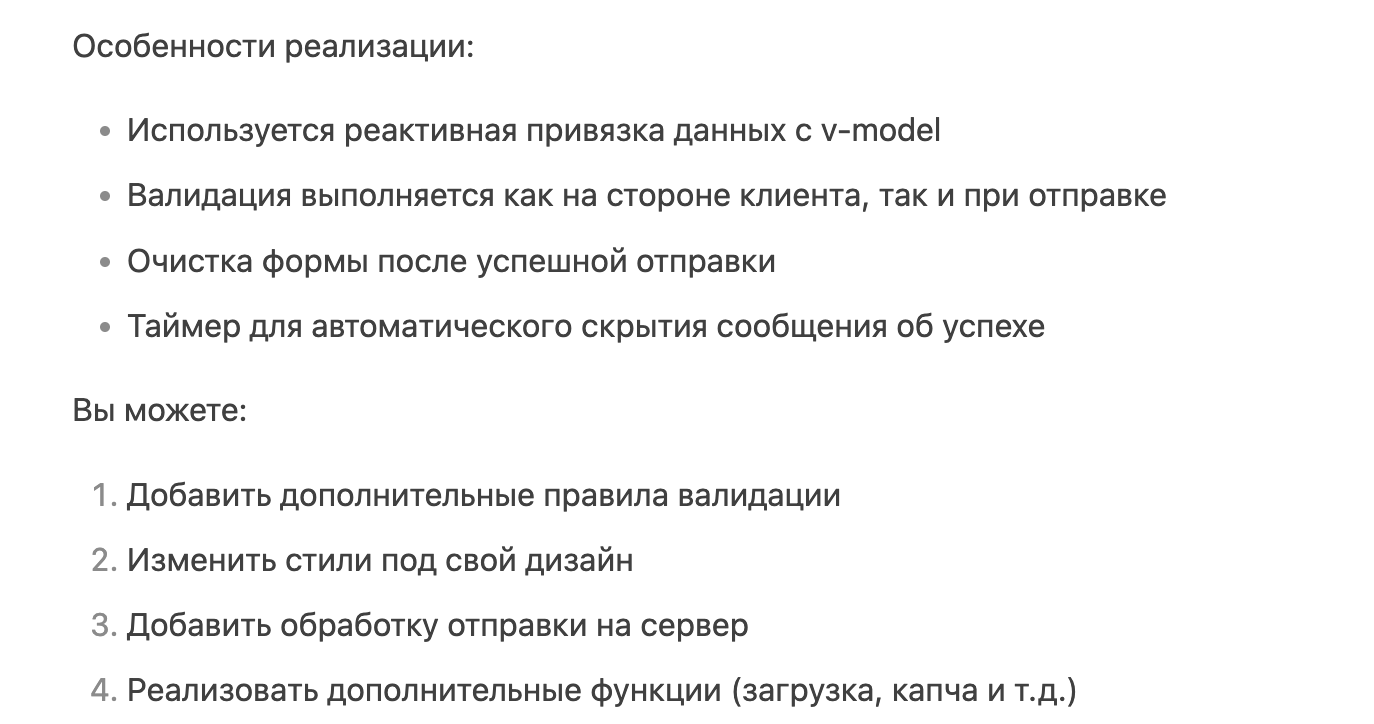

Прописала фичи, которые уже есть, и которые можно добавить:

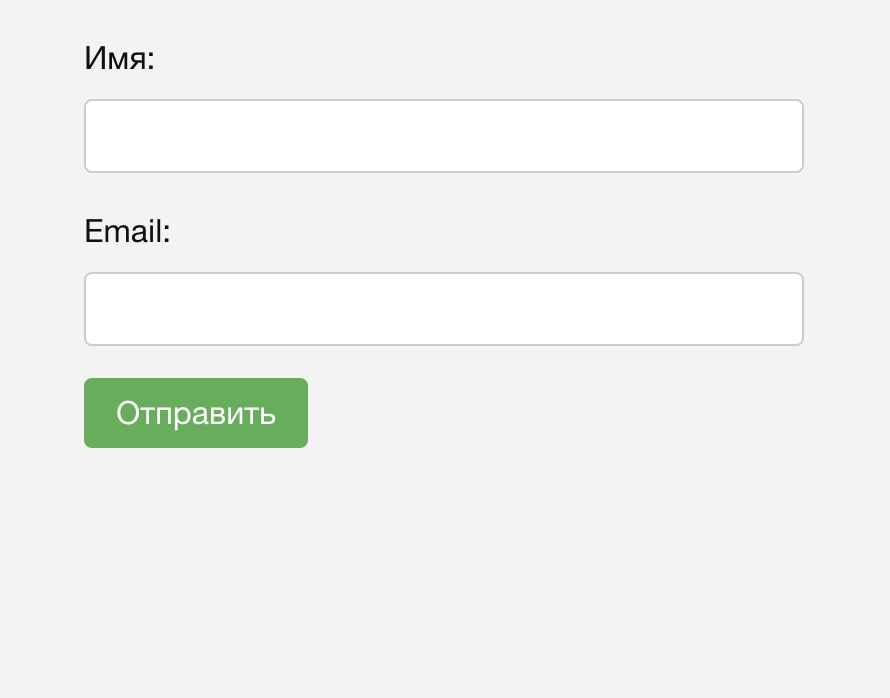

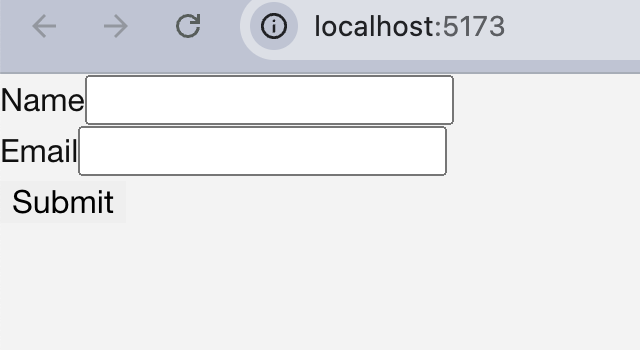

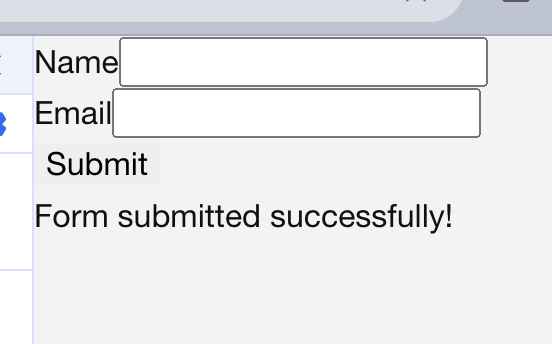

Тестируем в браузере. Выглядит хорошо:

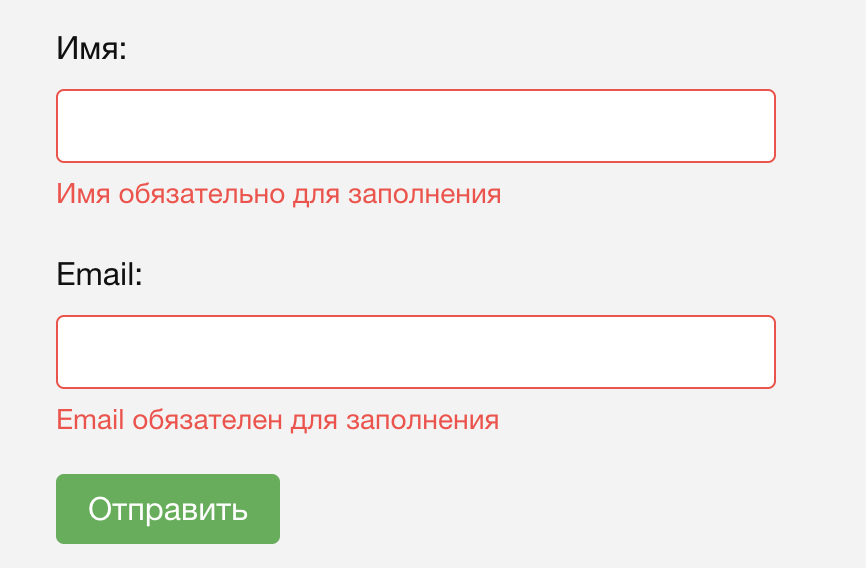

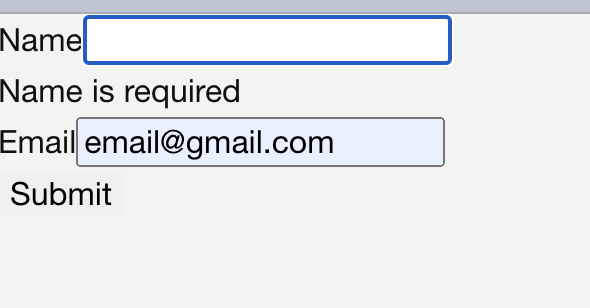

Проверяем валидацию. Проверка пустыми полями пройдена:

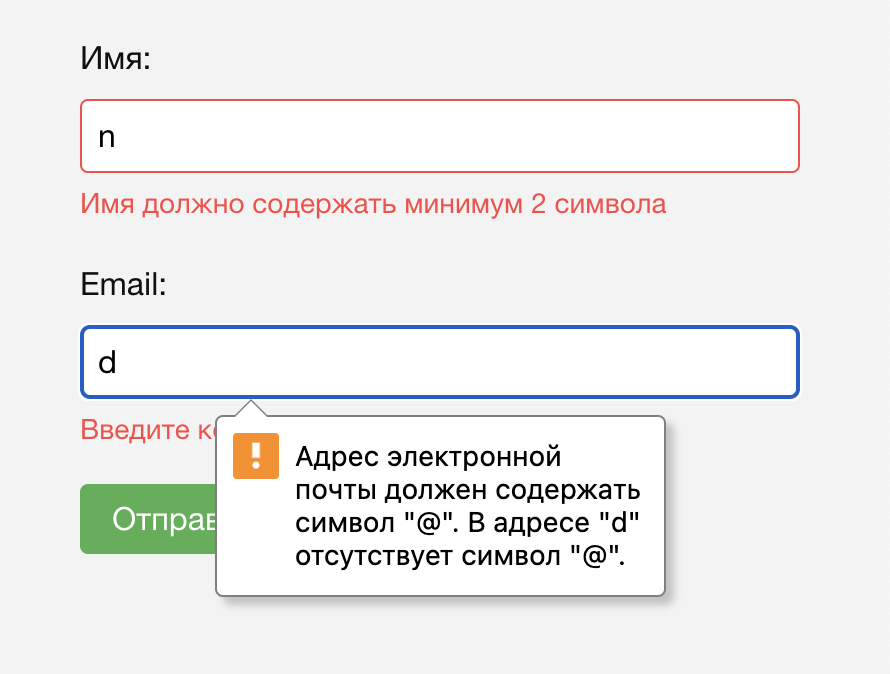

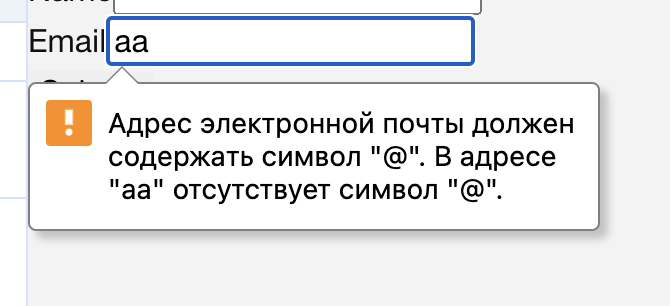

Теперь через некорректные значения. Тоже всё ок, даже добавлена валидация поля через html:

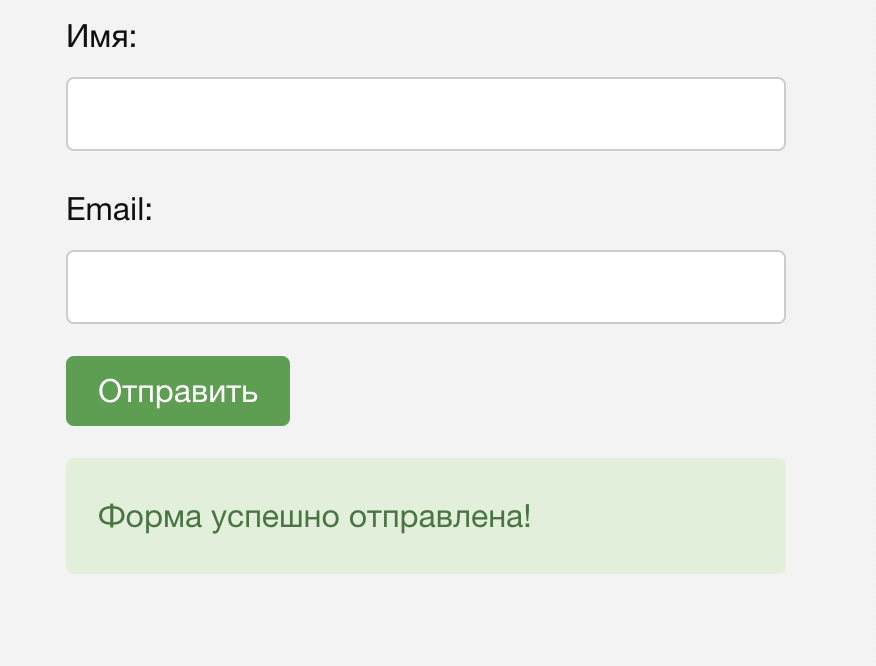

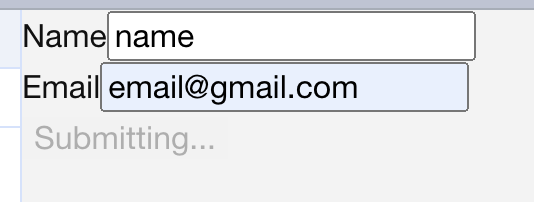

С корректными значениями форма отправляет данные, очищает поля и показывает оповещение. DeepSeek для этого добавил в код моковую отправку:

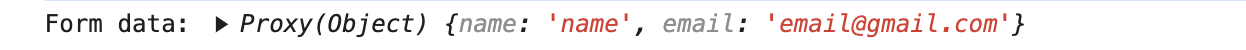

А в консоли можно посмотреть логи данных:

Ещё DeepSeek единственная смогла пройти проверку и не отправить на сервер пробелы вместо имени:

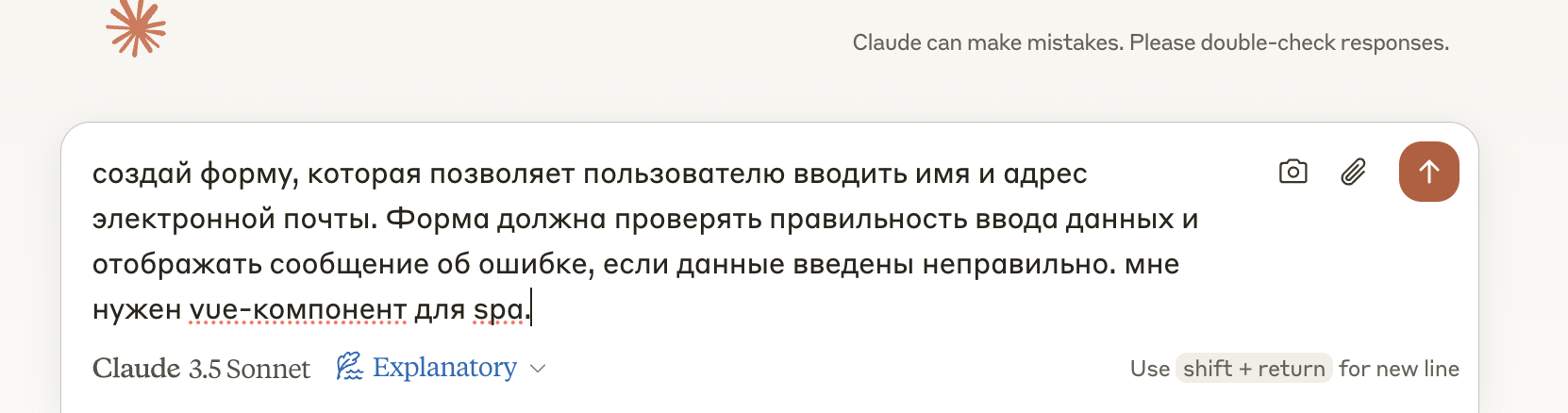

Теперь очередь Claude. Попросим сделать форму в режиме объяснения:

Форма:

Очень много кода получилось. Ну ладно, разбираемся.

Почему-то внезапно Claude решил забыть русский язык и выкатил описание компонента на английском. Странно, но терпимо. Зато добавил комменты в код:

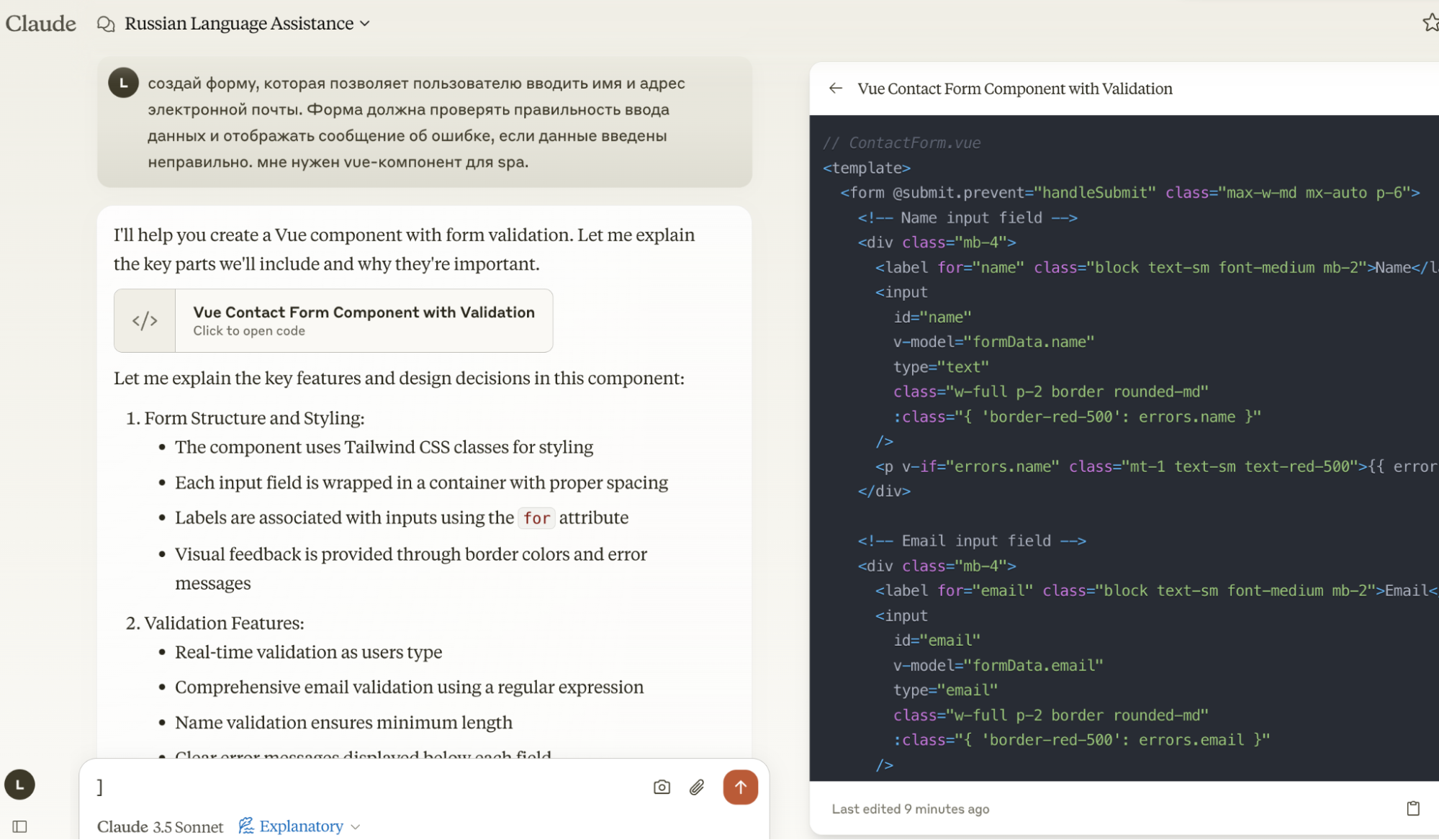

Из плюсов — ИИ объяснил, что это за компонент, как он устроен и что с ним делать:

Из минусов — мы не просили Tailwind, а в описании к коду нет никакого гайда, как его подключить. А ведь форму мог попросить новичок или ментор для быстрого примера на консультации.

DeepSeek стилизовал форму сам и очень даже симпатично. Claude так решил не делать. И в итоге без установленного Tailwind форма выглядит так:

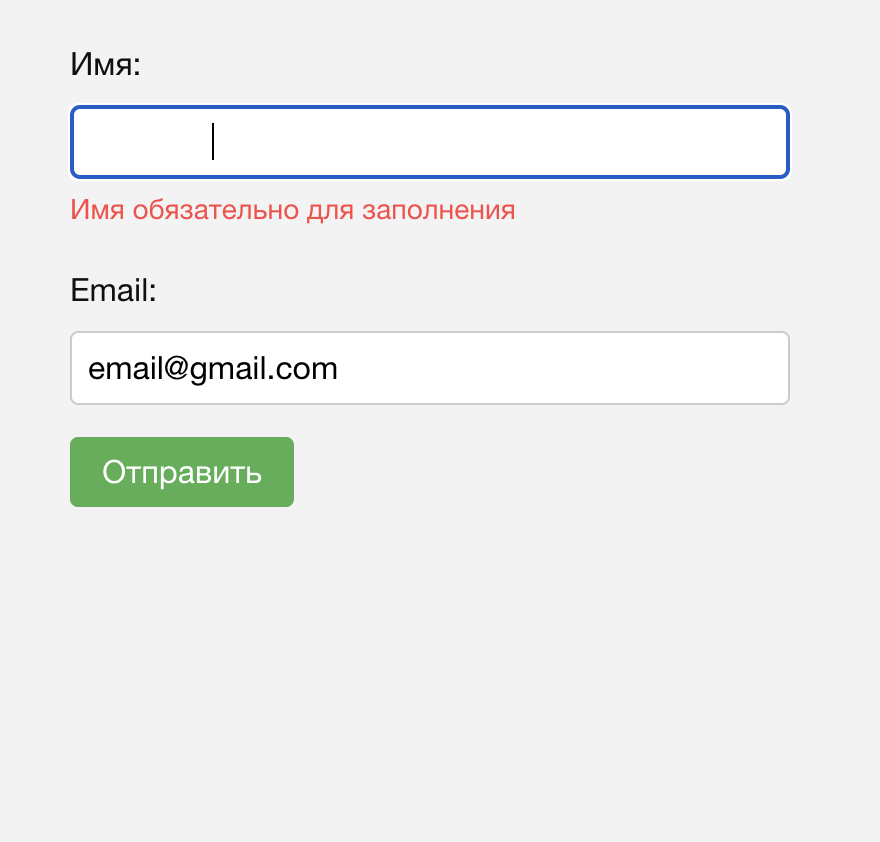

Опустим стилизацию и потестируем функционал. Валидация пустых данных есть:

Поля с пробелами не пропускает:

Есть встроенная в HTML валидация почты:

С корректными данными ответ уходит на «сервер»:

А затем поля очищаются и под формой появляется сообщение об успешной отправке:

Была бы эта форма ещё красивая без Tailwind, цены бы ей не было.

DeepSeek сделала круто, нареканий нет, заслуженный балл. А вот к Claude вопросики — к смене языка и внезапному появлению Tailwind. Так что только 0.5.

Счёт: DeepSeek — 1.5. Claude — 1.5.

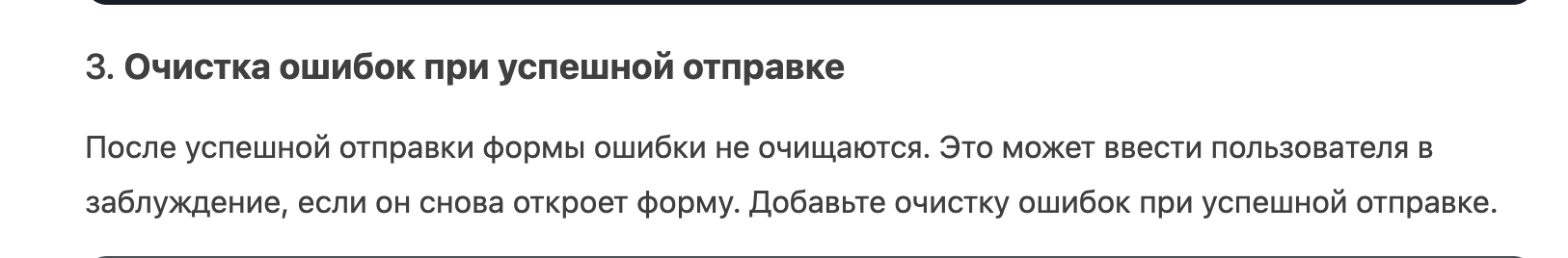

Раунд 3: Анализ кода

Финальный раунд — тестирование кода. Как и в прошлый раз, мы попросили нейросети проанализировать компонент формы победителя, оценить его и предложить улучшения.

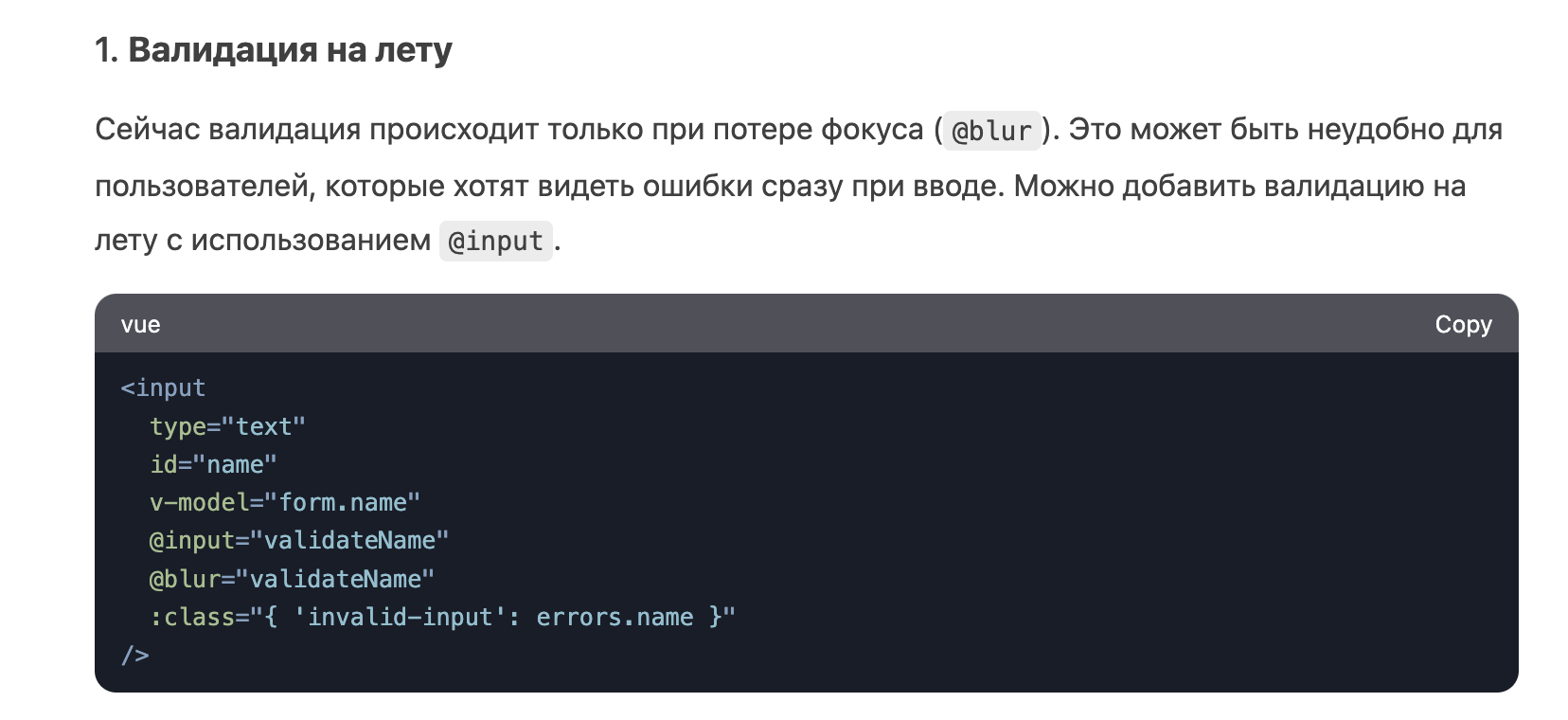

Попросим DeepSeek проанализировать свой же код:

Китайская нейросеть предложила мгновенную валидацию. Ну, не знаем, вкусовщина.

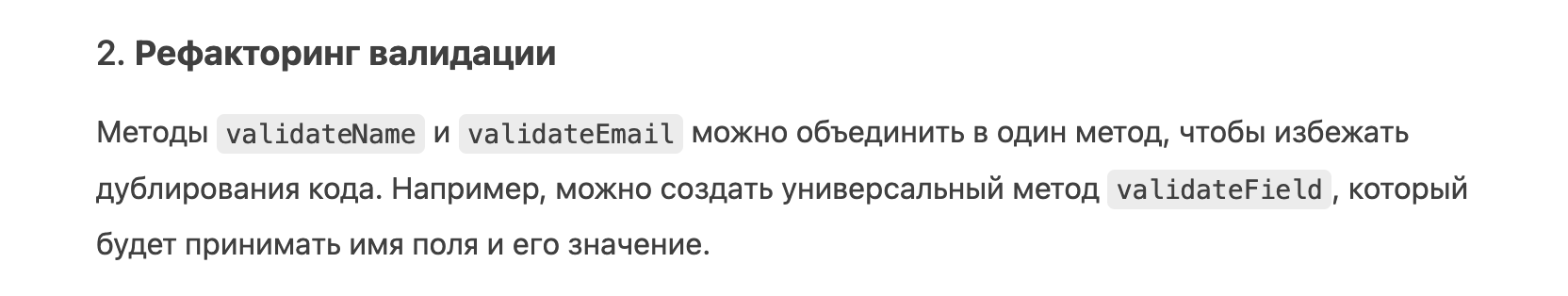

Да, идея хорошая, это оптимизирует код. Но ухудшает читаемость, так что вопрос приоритетов:

Сетка почему-то не увидела очищения полей. Ваше мнение, почему так? Они точно очищаются.

А ещё посоветовала библиотеки, которыми можно заменить кастомную валидацию:

И тоже предложила улучшить адаптивность:

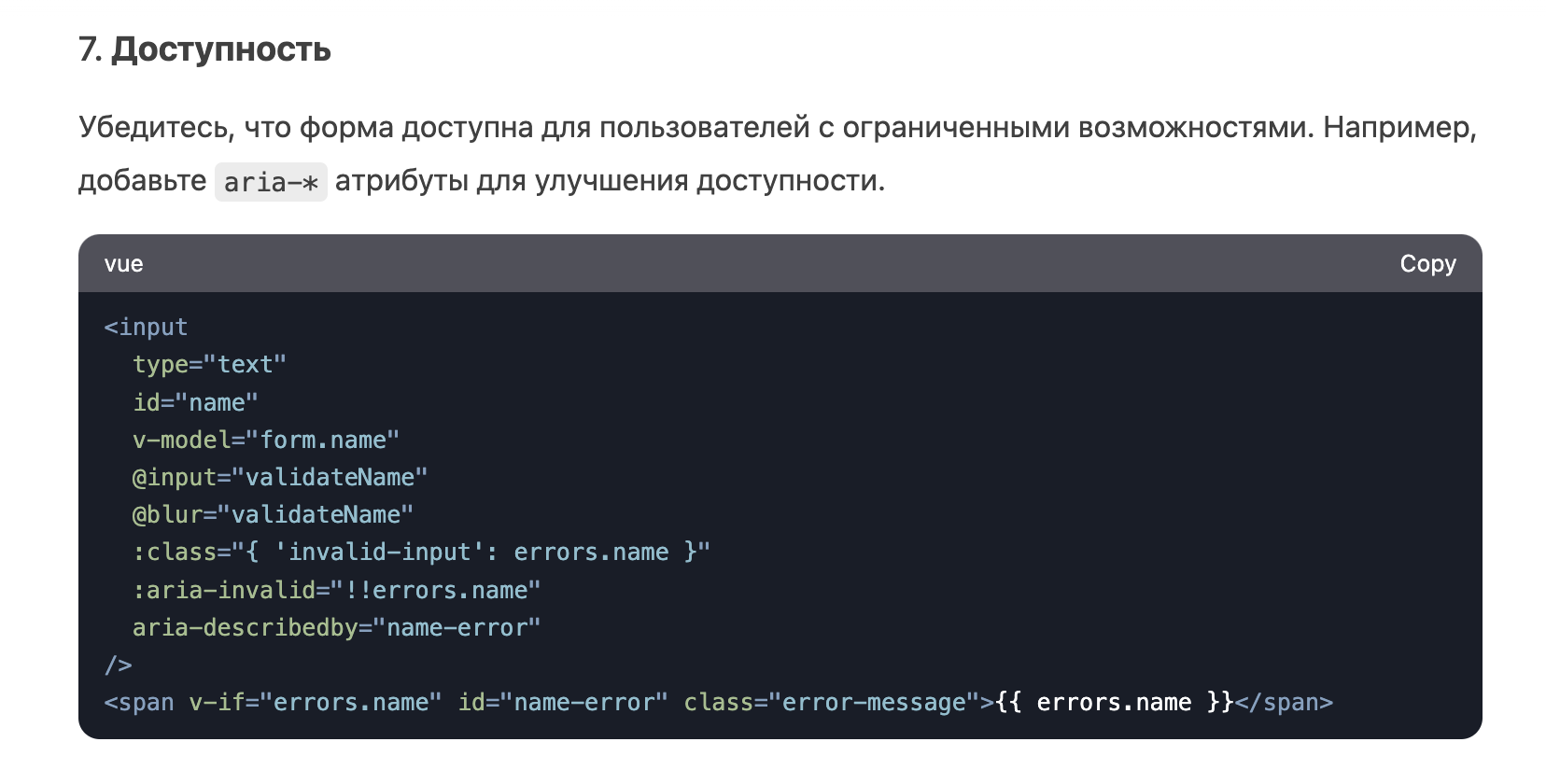

Теперь очередь Claude в режиме concise:

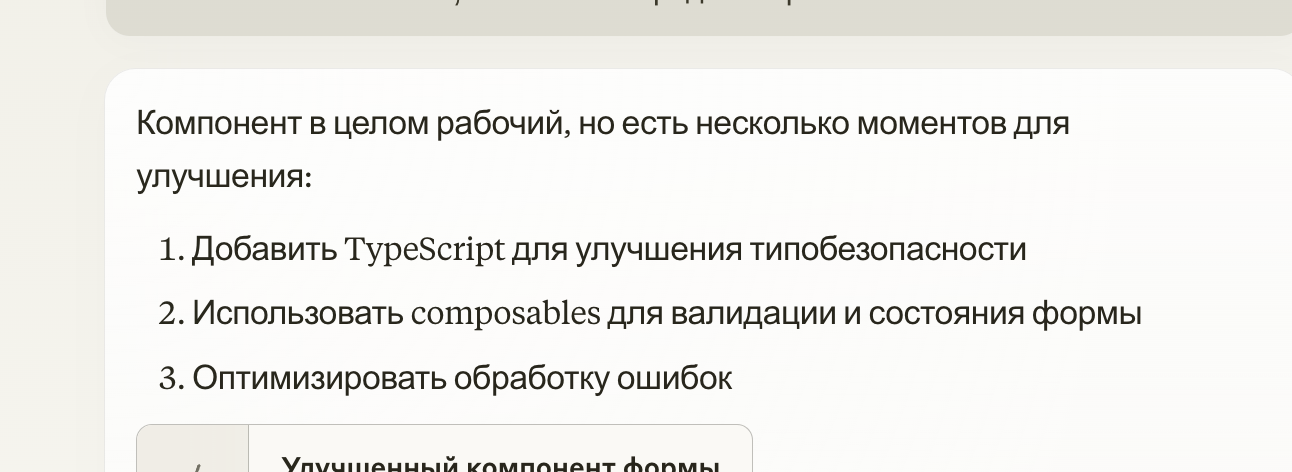

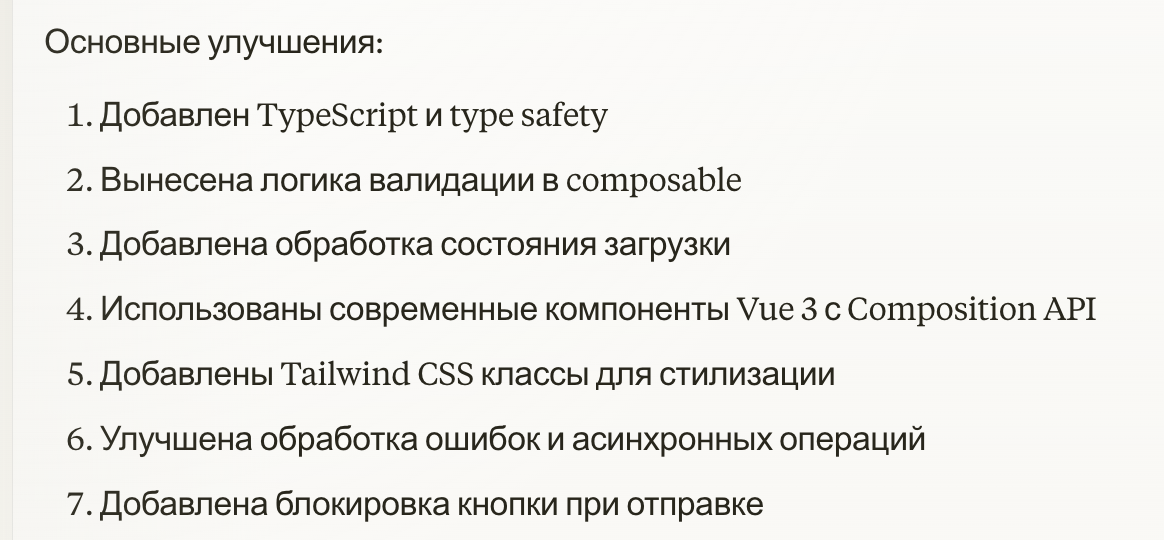

Посмотрим на результат:

Claude предложил добавить TS, что, на самом деле, валидное предложение, но это не улучшение компонента, а переход на новый уровень. А что, если проект на JS и не планирует переход на другой язык? Короче, спорно.

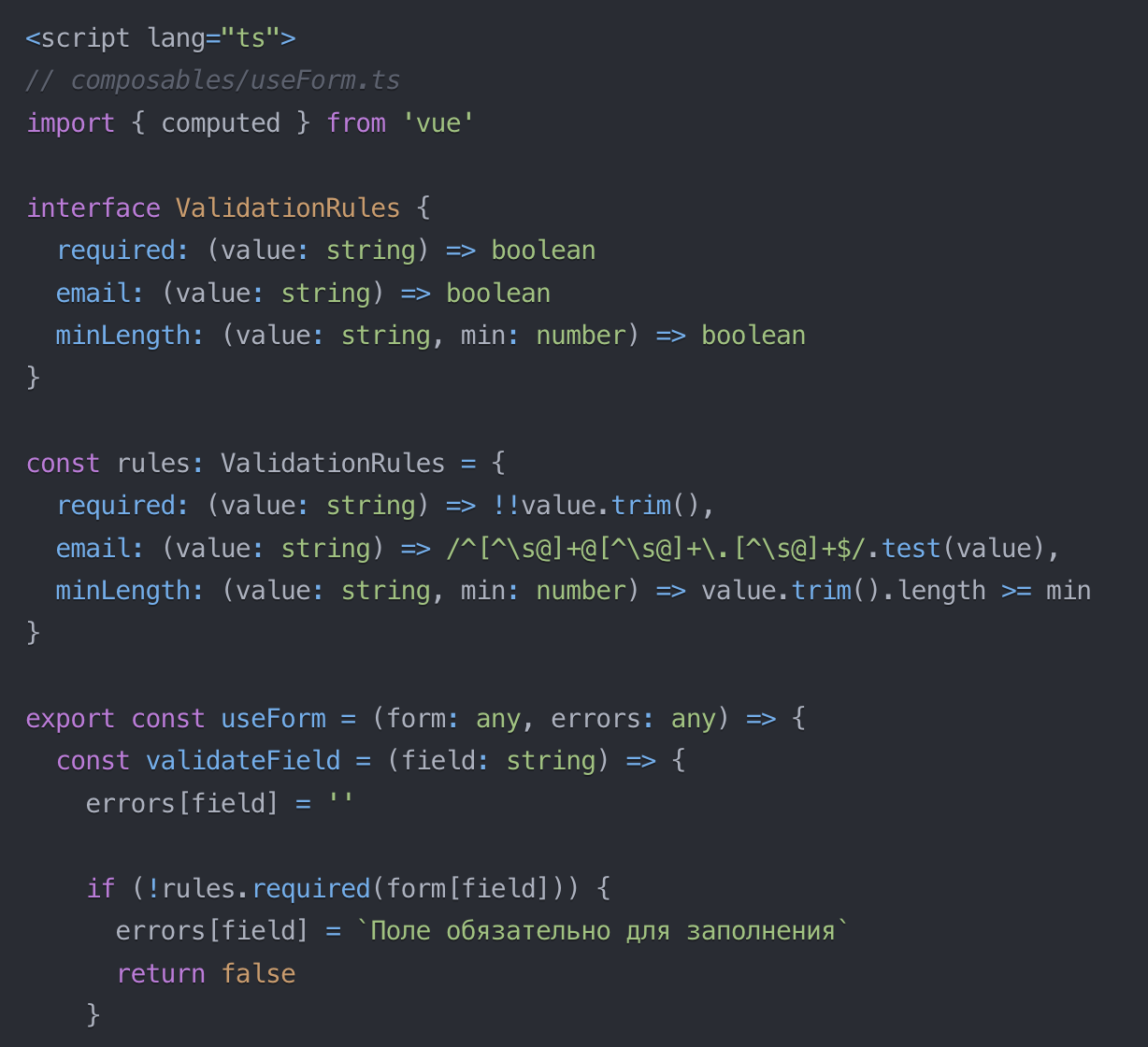

C composables согласны, и Claude даже предложил, как именно это сделать:

Ещё два плюса: заблокировал кнопку «Отправить», пока идёт отправка, и сделал более современный синтаксис скрипта — с помощью setup.

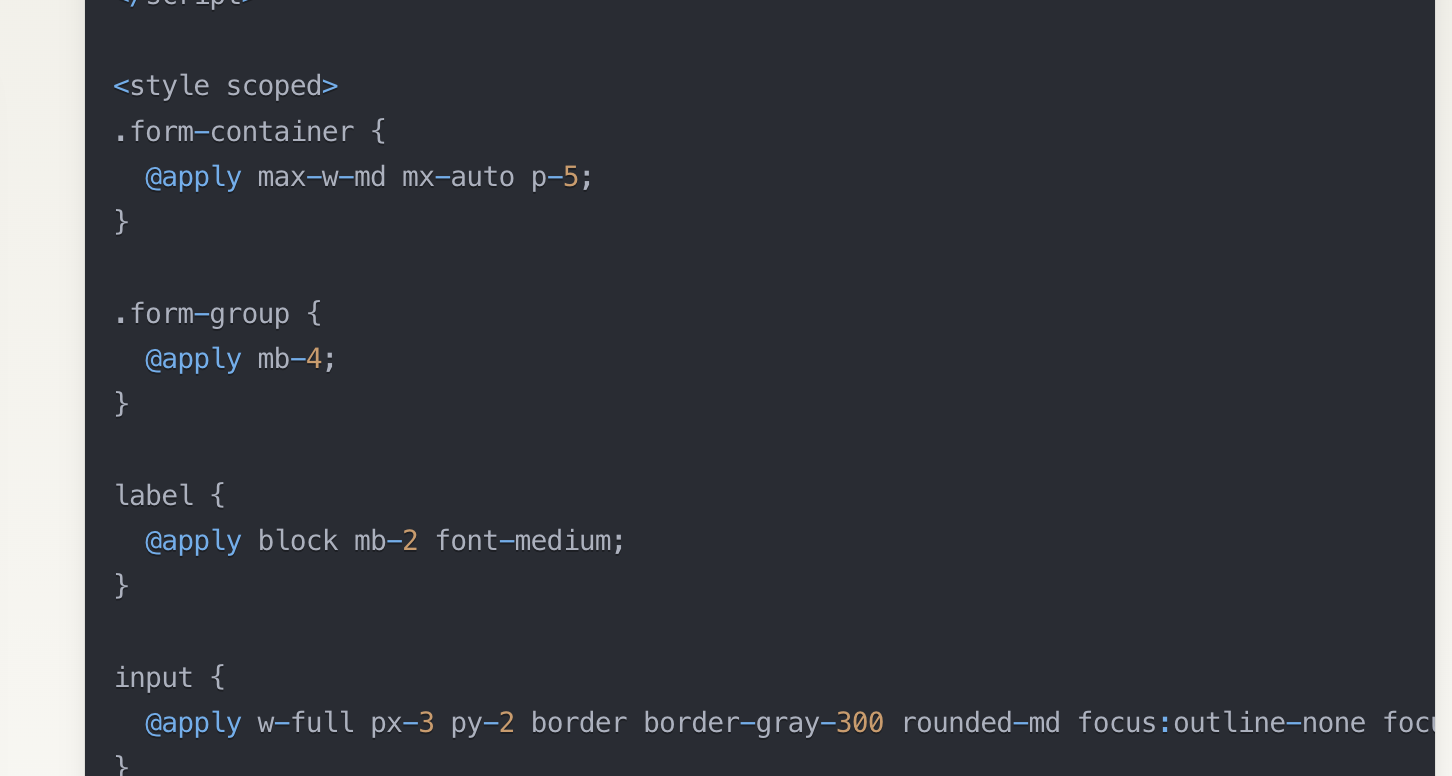

Но он опять впихнул Tailwind в компонент:

Кому, зачем? Риторические вопросы. Хотя нет. Давайте их зададим:

Claude не захотела отвечать, но свою неправоту признала. Ладно, прощаем.

Итоги. У обеих сеток были удачные и неудачные предложения. Но в целом — валидные. Разработчику бы они помогли. Поэтому поставим обеим по баллу.

Счёт: DeepSeek — 2.5. Claude — 2.5.

Итоги

Выявить победителя не получилось, обе сетки — крутые. Разве что картинки не рисуют, но со всем остальным справляются хорошо.

DeepSeek

Сильные стороны:

Отлично справляется со STEM-задачами, генерирует качественный код и успешно исправляет ошибки. Порадовала кастомной валидацией и структурированными ответами.

Слабые стороны:

Однако не обошлось без нюансов: периодически игнорировала Composition API и некорректно очищала поля ввода.

Claude

Сильные стороны:

Пишет хороший код с комментариями, чётко и понятно отвечает на вопросы. А ещё у неё классный интерфейс: очень приятные цвета и анимации.

Слабые стороны:

Везде пихает Tailwind. И не отвечает, почему. Подозрительно.

***

Мы не поняли, что лучше — DeepSeek или Claude. Но поняли, что и то, и то — классные инструменты, которые легко спасут фронтендера от рутины. Выбирайте, что хочется, или вообще комбинируйте все четыре сетки, о которых мы писали. Кто вам запретит? 🙂

2К открытий7К показов