Естественный голос, болевые точки и обман: как мошенники используют ИИ

«Я спросил, мошенники они или нет. Они сказали, что нет». Сегодня технологии ИИ позволяют обманывать людей и вымогать с них деньги. Рассказываем о пяти таких схемах и даем рекомендации, как не стать жертвой.

603 открытий5К показов

Вы когда-нибудь задумывались, как современные мошенники используют искусственный интеллект, чтобы обманывать ничего не подозревающих жертв? Поверьте, таких случаев много и обязательно будет больше. Важно не просто знать о схемах, но и уметь защищать себя.

Показательный пример. В конце июня 2024 года сервис Booking.com предупредил своих клиентов об угрожающем росте мошеннических схем в сфере туризма, связанных с использованием технологий ИИ. По предварительным оценкам, за последние полтора года количество таких махинаций увеличилось более чем на 500%.

Особенно заметен всплеск фишинговых атак, когда людей обманным путем принуждают предоставить свои финансовые данные. Исследователи безопасности объясняют это запуском ChatGPT, который способен весьма убедительно имитировать электронную переписку с реальными специалистами.

Чтобы обезопасить себя, рассмотрим пять самых распространенных мошеннических схем и дадим рекомендации каждому, кто потенциально может столкнуться с проблемой (поверьте, это будут все читатели текста).

Схема 1. Голосовые дипфейки

Голосовые дипфейки — это технологии, позволяющие с помощью ИИ синтезировать голос, который звучит почти идентично голосу реального человека.

Как работает схема

Такие системы могут создать аудиозапись, имитирующую голос конкретного человека с точностью до тембра и интонации. Это может быть использовано для того, чтобы обманом заставить жертву выполнить определенные действия (отправить деньги на лечение, подписать документ и т.д.)

И если раньше при взломе аккаунта мы писали мошеннику: “скинь голосовое, что это ты”, — теперь такой способ не поможет. Технология достаточно доступна и используется не первый год, поэтому голосовые получаются правдоподобными.

Реальные случаи

Одним из известных примеров был случай, когда в 2019 году злоумышленники использовали голосовой дипфейк, чтобы обмануть руководителя одной из британских компаний и перевести около 243 000 фунтов стерлингов на подконтрольные им счета. Руководитель компании, будучи уверенным, что разговаривает со своим начальником, распорядился о переводе средств.

Еще один пример — использование голосовых дипфейков в политической сфере. В 2020 году в США появилось видео, на котором якобы кандидат в президенты Джо Байден делает оскорбительное высказывание. Однако впоследствии выяснилось, что это был высококачественный голосовой дипфейк, созданный с целью повлиять на общественное мнение.

Схема 2. Дипфейк видео

Дипфейк видео позволяют создавать поддельные ролики, в которых человек, изображенный на записи, якобы совершает определенные действия или произносит слова, которых на самом деле не было.

Как работает схема

Эта технология основывается на генеративных нейросетях, которые обучаются на большом количестве изображений или видео одного человека и затем воспроизводят его движения и мимику на новой записи.

Сейчас видео могут быть как в записанном формате в виде кружочков в телеграм, так и в реальном времени в формате наложения маски. Поэтому понять, реальный ли перед вами человек — практически невозможно. Однако есть несколько отличительных черт. Сбер создал обучалку, которая может помочь распознать дипфейк на видео.

Реальные случаи

В январе этого года сотрудник транснациональной компании в Гонконге перевел мошенникам $25 млн после созвона с «коллегами». Пострадавший получил приглашение от якобы финансового директора фирмы на онлайн-видеовстречу, где планировалось обсудить некую конфиденциальную сделку. Оказалось, что все присутствовавшие на созвоне «руководители компании» были дипфейк-имитацией. Они убедили сотрудника перевести $25,5 млн из средств фирмы на пять банковских счетов. Как говорится, жалко, конечно, этого добряка.

Схема 3. Фишинг и мошеннические веб-сайты

Фишинг — это тип атаки, при котором мошенники пытаются получить конфиденциальные данные, выдавая себя за законные организации или лица.

Как работает схема

С помощью ИИ злоумышленники могут анализировать огромные объемы данных, чтобы персонализировать свои атаки, делая их более убедительными и целевыми. Например, технологии используются для создания фальшивых электронных писем, которые по стилю и содержанию неотличимы от реальных.

Также сюда относится создание копий сайтов с целью завладеть персональными данными пользователей. Например, С помощью ИИ генерируется статья, где пишут: «Васю Пупкина слили в сеть, люди узнали, чем он занимается наедине». Читатель переходит по ссылке и теряет свои данные.

Причем определенные знания или навыки работы с ИИ не нужны. Все автоматизировано. Так, на видео (с 15:42 ) видно, как парень создает фишинговую статью и легко обманывает человека

Реальные случаи

К слову о фальшивых статьях— одна из таких была написана о «сливе» личных данных знаменитости. В 2022 году исследователи из компании Avast обнаружили, что хакеры используют ИИ-генерированные статьи и поддельные сайты, чтобы заманивать пользователей и красть их личные данные. Например, одна такая статья имитировала расследование об утечке личной информации известной личности.

Схема 4. Создание профилей-копий

Как работает схема

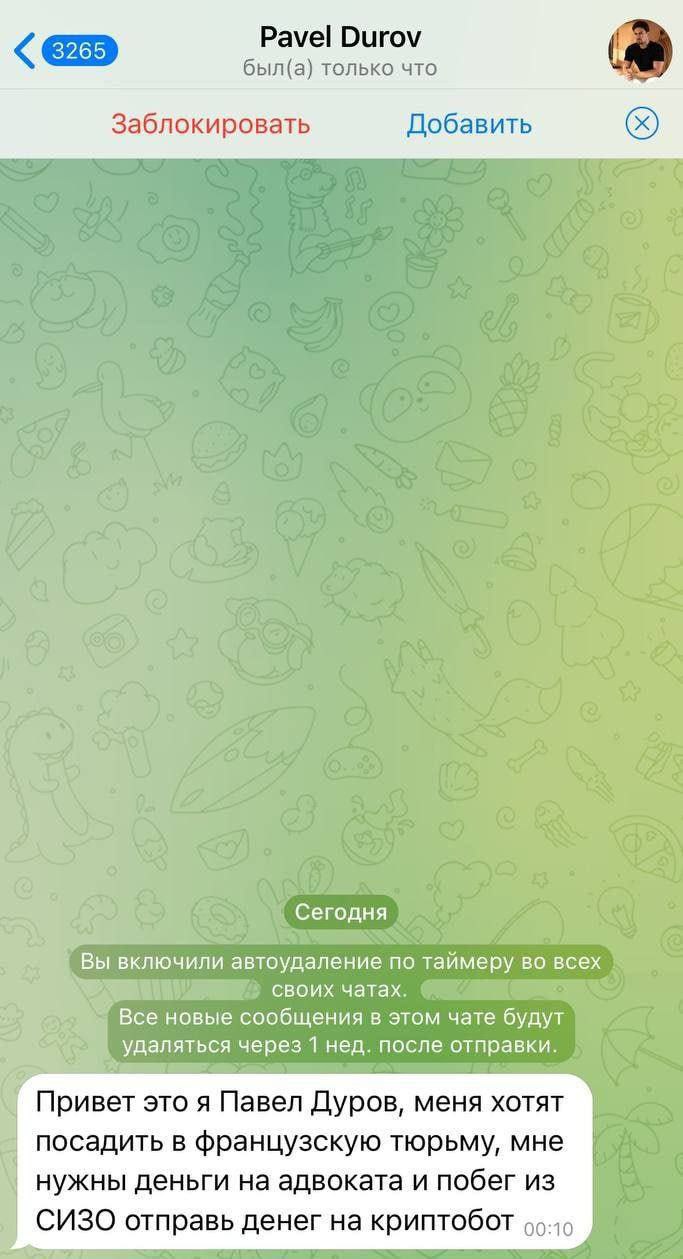

Мошенники создают копию аккаунтов разных людей (политиков, блогеров, артистов, родственников и даже вас) в социальных сетях. С помощью нейросети они могут, например, как отправить голосовое сообщение, так и быстро общаться в определенном стиле в переписке.

Реальные случаи

- Фальшивый аккаунт главы Европейского центрального банка. В 2022 году исследователи обнаружили поддельный аккаунт Кристин Лагард, президента Европейского центрального банка, в социальной сети LinkedIn. Используя ИИ-сгенерированные фото и данные, мошенники пытались выдать себя за реальную личность, чтобы получить доступ к конфиденциальной информации.

- Копия аккаунта российского военачальника. В 2022 году специалисты по кибербезопасности выявили фейковый аккаунт российского генерала Сергея Суровикина в Telegram. Мошенники использовали его фотографию, а также ИИ-генерированную речь для общения с его подчиненными. Цель — получение закрытой информации.

- Поддельный профиль известного блогера. В 2021 году были обнаружены мошеннические аккаунты популярного российского видеоблогера в социальных сетях. Используя технологии синтеза голоса и текста, злоумышленники вели от его имени переписку с подписчиками и собирали их личные данные (а кого-то разводили на деньги).

Схема 5. Откровенные дипфейки с целью шантажа

Один из наиболее тревожных и разрушительных способов использования ИИ мошенниками — создание откровенных дипфейков с целью шантажа. Эти видео или фотографии создаются с использованием алгоритмов глубокого обучения и могут изображать людей в компрометирующих ситуациях, которых на самом деле никогда не происходило.

Как работает схема

Злоумышленники получают изображения или видео с жертвой, которые затем обрабатываются с помощью технологий ИИ для создания реалистичных откровенных дипфейков (достаточно ваших фото в открытом доступе). Эти ролики могут быть отправлены жертве с угрозами распространения, если не будет уплачена определенная сумма денег. В некоторых случаях жертвы даже не подозревают о том, что видео поддельное, и поддаются шантажу из страха потерять репутацию.

Если с вами создали откровенный дипфейк, можно наказать преступника. Сейчас в УК есть несколько статей, за которые привлекают к ответственности: Вымогательство (ст. 163 УК РФ), Незаконное получение изображения (ст. 137 УК РФ), Распространение порочащих сведений (ст. 128.1 УК РФ), Распространение порнографических материалов (ст. 242 УК РФ)

Реальные случаи

В 2019 году появились сообщения о том, что неизвестные лица используют технологии глубокого обучения для создания поддельных порнографических видео с известной актрисой Галь Гадот. Злоумышленники угрожали распространить эти материалы, если не получат выкуп. Тогда инфополе впервые столкнулось с масштабным фейковым «сливом».

А в 2021 году студентку из Бразилии шантажировали с помощью поддельных интимных фотографий, сделанных с использованием ИИ. Злоумышленники требовали от нее денег, угрожая распространить эти материалы. Это один из самых популярных способов.

Как не стать жертвой

Мошенники — это не новость. Представляем небольшой чек-лист, который поможет обезопасить себя.

✓ Будьте осторожны с неожиданными запросами на переводы. Если вам звонят с просьбой срочно перевести деньги, всегда проверяйте информацию, особенно если речь идет о крупных суммах.

✓ Используйте многофакторную аутентификацию. Голосовая аутентификация может быть уязвима, поэтому лучше использовать несколько факторов, включая SMS-коды или биометрию.

✓ Проверяйте источники информации. Если вы видите или слышите подозрительную информацию от якобы известных личностей, проверяйте её через официальные каналы.

✓ Звоните на личный номер или организуйте встречу, а также задавайте наводящие вопросы, если не уверены, что перед вами тот самый человек. Мошеннику не всегда удастся быстро и без промедлений ответить на такие вопросы как: возраст, имя, улица проживания, ваше место знакомства, имя домашнего питомца и так далее

✓ Будьте в курсе новых угроз. Следите за новостями в области кибербезопасности, чтобы быть осведомленным о новых схемах мошенничества.

✓ Регулярно обновляйте пароли и избегайте использования простых комбинаций.

✓ Завершайте сеансы на всех устройствах, кроме основного.

А вы сталкивались с ИИ-мошенниками? Делитесь в комментариях.

603 открытий5К показов