Как строить Data Office: опыт «Ростелекома»

Рассказываем, какие этапы прошли, создавая дата-офис в «Ростелекоме»: от инвентаризации проектов до формирования data-driven культуры.

1К открытий10К показов

Продолжим тему Data Office в новой статье. Многие компании сейчас выстраивают собственные подразделения, работающие с данными. Централизация дата-процессов экономит время и силы, избавляет от рассинхрона по данным, а со временем повышает рентабельность всего бизнеса. Но это только в том случае, если все процессы построены правильно. С чего начать и к чему идти в создании дата-офиса? О чём важно помнить специалистам, которые этим займутся? Расскажем на собственном опыте.

Марина Кормщикова

Менеджер продукта «Нейрошлюз» ПАО «Ростелеком»

Борис Емельянов

Технический директор Платформы данных ПАО «Ростелеком»

Data Office в «Ростелекоме» стал зарождаться в 2017-2018 годах после появления единого технологического хранилища. Получив первые успешные проекты на централизованной платформе, мы задумались о такой же централизации работы с данными. До этого данными в разных подразделениях занимались обособленно.

Когда у тебя одно хранилище данных, ты тратишь N денег, когда два — затраты возрастают уже десятикратно, потому что кроме софта появляется обслуживающий персонал, дорожают внутренние процессы. А потом люди перестают понимать, куда идти за данными. У всех получаются разные результаты, и начинаются конфликты.

Как мы выстраивали Data Office

Шаг № 1. Провели инвентаризацию всех проектов и создали единый контур

В любой современной компании обязательно есть процессы управления данными даже при отсутствии единой политики. Поэтому первый шаг к созданию дата-офиса — проанализировать все проекты, где есть работа с данными, информацией, аналитикой. Понять, какие из них целевые, что объединить и так далее, а затем создать архитектуру всех этих взаимосвязанных решений.

У каждого отдельного бизнеса уже было собственное хранилище данных, и нам потребовалось разобраться во всех внутренних процессах, завязанных на эти хранилища (продажи, техподдержка, обслуживание клиентов) прежде, чем переключать всё на единую систему.

Важно подумать над технической архитектурой централизованного контура, на котором будет развиваться отчётность. Продумывать его нужно не только под сиюминутные задачи, но и на перспективу: заложить возможности для масштабирования, понять, какие аналитические кейсы на нём можно будет разворачивать. Даже если сейчас у вас есть живая потребность только в аналитическо-регулярной отчётности, пакетной доставке и обработке, завтра на этих же данных нужно будет подключать команды для подготовки данных для ML-моделей, для realtime отчётности и так далее.

Шаг № 2. Объяснили подразделениям и командам плюсы перехода

Замена привычных рабочих процессов на что-то новое естественным образом вызывает дискомфорт и недовольство. Тем более что преимущества централизации видны не сразу: сначала нужно пройти сложные процессы создания и отладки единой модели, и только спустя время мы наблюдаем и качественный, и количественный эффект.

К тому же на сотрудников накладывалась дополнительная нагрузка. В сегменте B2C при переходе на централизованное хранилище коллегам приходилось не только отвечать за аналитику движения клиентской базы, но и настраивать все потоки данных и выверять методику расчёта показателей.

Мы находили наиболее лояльных партнёров из бизнеса и реализовывали с ними проекты в новом подходе, тем самым укрепляя его авторитет благодаря более эффективному результату. Мы отказались от ручных операций: сейчас в бизнес-сегментах данные, сформированные по единой методологии, загружаются напрямую в управленческую отчётность. Бизнес начал углублять аналитику, ставить адресные задачи и в целом качественнее контролировать процесс. Уменьшились и совокупные затраты во всей компании, в том числе за счёт отказа от вендорских лицензий и перехода на нашу платформу управления данными.

Шаг № 3. Определились с технологическим стеком и подготовили специалистов

Мы понимали, что количество систем в ландшафте компании со временем будет только увеличиваться, и у нас должна быть возможность быстро забирать данные через любые способы интеграции. Поэтому при выборе архитектуры важными факторами были универсальность и быстрая масштабируемость.

Решить задачу построения платформы, опираясь на классическую модель построения DWH с участием крупных вендорных appliance, не получилось бы. Мы стали смотреть в сторону software-based и open-source based решений. В качестве ядра системы выбрали Hadoop и Greenplum — гибкие и хорошо масштабируемые инструменты, со взаимной совместимостью и большой экосистемой сопутствующих технологий.

Не забыли и про TCO таких продуктов: часто за низкой стоимостью лицензий скрывается высокая стоимость сопровождения. Чтобы эффективно использовать такие решения, мы привлекли опытную экспертную команду.

Шаг № 4. Предусмотрели решение текущих задач по данным

Главная проблема — заказчики не будут ждать, пока мы сделаем красивый ландшафт, построим хранилища и разберёмся, как работать с новыми технологиями. Данные им нужны здесь и сейчас. Поэтому важно отстроить процессы так, чтобы давать бизнесу готовые аналитические решения и параллельно внутри развивать идеальный дата-офис.

Так, у нас появились два направления: фабрика аналитической отчётности, где за каждый сегмент бизнеса отвечал отдельный фронт-менеджер, и проектное направление, которое закрывало технический долг и развивало техническую составляющую. В нём строили централизованное хранилище, потоки, справочники, работали над качеством и защитой данных: с одной стороны, помогали «фронтам», чтобы они делали отчётность здесь и сейчас, а с другой — продумывали правила, которые из состояния стартапа помогут перейти на промышленные рельсы.

Слаженный Data Office должен быть универсальным и легко масштабируемым, требования к оборудованию должны быть простыми, преимущественно с базой из известных решений с открытым исходным кодом. Такой подход даёт гибкость и стабильность поддержки при сравнительно низкой ТСО.

Шаг № 5. Формирование data-driven культуры в компании

Мы уделяем много времени и сил обучению сотрудников работе с данными и формированию data-driven мышления. Проводим «мягкие» программы, где разбираем, как Amazon и Google поднимают рентабельность своего бизнеса с помощью анализа данных. Запускаем «хардовые» программы, где учим работать с BI-дашбордами, базами данных, Hadoop и другими техническими инструментами. Так, после программы по работе с нейросетями у нас на портале зарегистрировалось 600 новых пользователей.

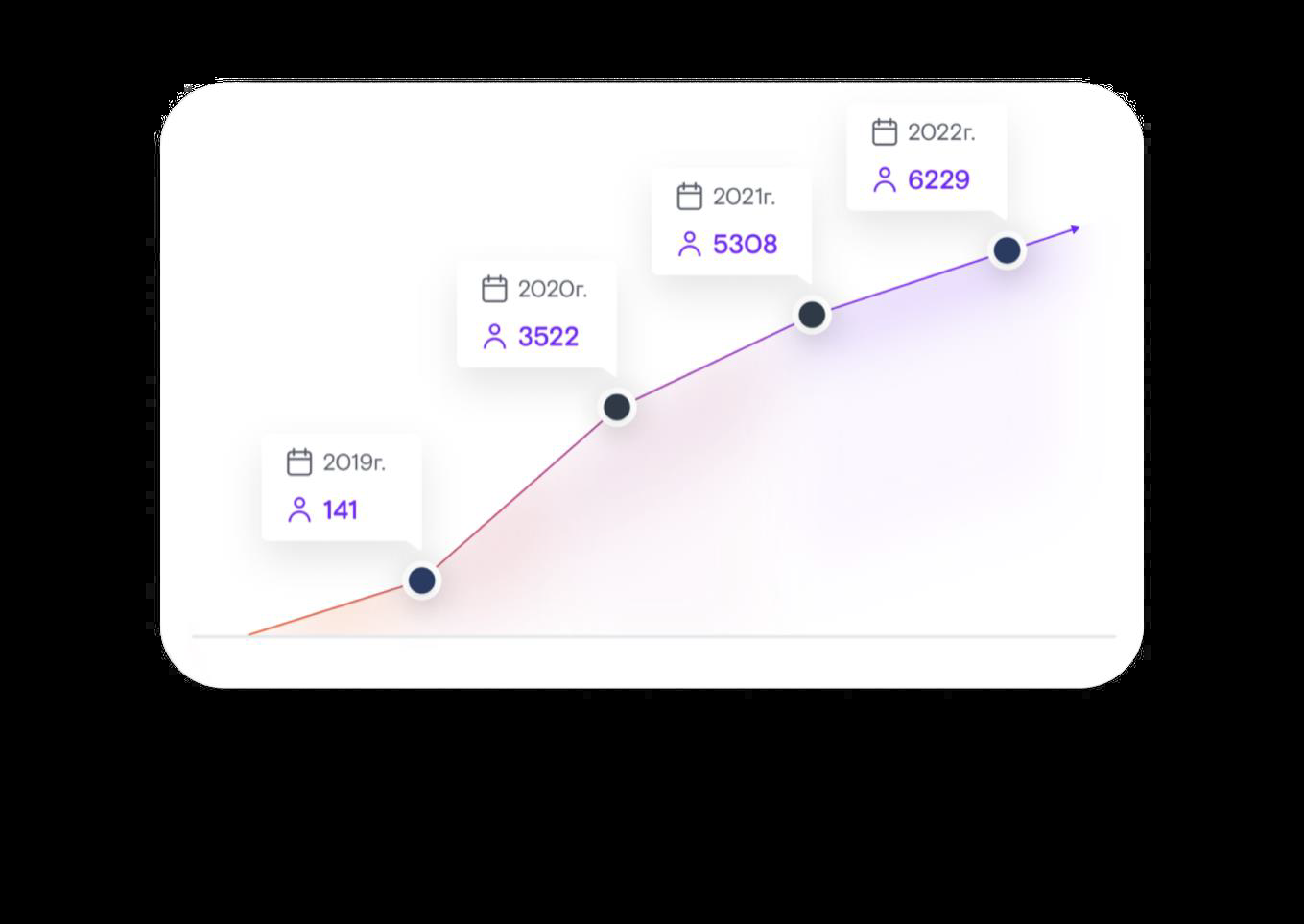

Есть и внешняя история: в 2019 году мы создали бесплатный общедоступный проект DataTalks. Изначально мы планировали обучать работе с данными студентов, но в итоге на программу пришли и действующие дата-специалисты, и даже CDO нескольких компаний.

При становлении дата-офиса важно разработать и установить правила игры: определить, что такое работа с данными, из каких ролей и процессов она состоит, каковы обязанности всех участников процесса сбора, анализа и интерпретации данных предусмотрены в общей стратегии. По сути, это законодательный орган, который регламентирует работу с данными для всех многочисленных подразделений и проектов, нынешних и будущих, и минимизирует риск «рассинхрона». В Ростелекоме мы назвали его политикой по управлению данными.

Как определить, что всё получилось

По этим метрикам мы определяем, что подразделение устоялось и Data Office стал эффективной функцией бизнеса.

Количество обращений растёт. С нашим внутренним порталом данных работает в среднем шесть тысяч пользователей ежемесячно.

Бизнес не пытается создавать централизованные решения у себя «под столом». Даже если бизнес не может найти готовые шаблоны по отчётам и аналитике, он приходит и решает свои задачи с помощью нашей централизованной инфраструктуры.

Отсутствует текучка кадров. Если люди не понимают целей и задач, не понимают, какую пользу приносят бизнесу, они быстро увольняются. В нашем случае основная команда не менялась с 2019 года: то есть люди, которые начинали Data Office, остались и продолжают расти внутри подразделения.

Продукт обновляется. Мы совершенствуем доступность системы, скорость подготовки регулярных данных и ряд других технических характеристик: мы начинали с ежемесячных отчётов, но сейчас практически все дата-продукты переведены на ежедневное обновление.

Пайплайн управления загрузками стал стабильнее. Мы руководствовались такими принципами, чтобы ускорить работу с продуктами:

- автоматизировали процессы, создав шаблоны загрузки данных и прописав логику выбора шаблона на основе метаданных;

- разбили процессы на атомарные этапы, описав в репозитории шаги по загрузке, проверке, синхронизации, сбору статистики и так далее;

- определили порядок выполнения задач по принципу FIFO, чтобы они регистрировались, а не выполнялись немедленно;

- настроили дискретно-непрерывные загрузки.

Мы наладили системную работу с источниками: обучили для этого команду поддержки, увеличили мощности инфраструктуры, выровняли расписания регламентных процессов.

Также для хранилища выстроили чёткое расписание и управление ресурсами: для наполнения данных мы максимально используем ночные часы, а дневные — для их потребления. Мы учитываем блокировки и руководствуемся выстроенной логикой зависимостей таблиц.

Сейчас за месяц мы обрабатываем 300 тыс. процессов и 1,5 млн операций. Около 85% загрузок из источников в ODS реализуются на готовых процессах. На разработку новых процессов загрузок в DDS и витрин разработчики тратят считаные минуты, уделяя основное время реализации и отладке бизнес-логики.

Есть финансовый эффект. Каждый дата-продукт и сервис мы измеряем с точки зрения отдачи инвестиций. Самый простой пример с Data Science: DS-модели позволяют нам продавать больше услуг клиентам или улучшать сервис.

О чём важно помнить, создавая Data Office?

- При формировании новых правил не стоит резко ломать существующие: только помогать и дополнять.

- Фокусироваться не только на техническом решении задач, но и на бизнес-смыслах. Создавая решение просто по ТЗ, мы получим то, что будет работать, но не даст того бизнес-эффекта, который мог бы быть, или вообще окажется бесполезным. Нужно больше сотрудничать с бизнесом, чтобы понимать сценарий дальнейшего клиентского использования.

- Осмысленная работа с задачами поможет не перегореть сотрудникам нового подразделения: так они будут понимать, что «не просто кирпичи складывают, а строят храм».

- Важно объяснять всем участникам процесса, что работа с данными — это не только обязанность одного маленького подразделения, но и работа всей компании. Заказчики должны понимать, для чего нужны данные, какие инсайды из них можно получить — и работать над тем, чтобы эти качественные данные у компании были.

Мне кажется, идеальный дата-офис с точки зрения бизнеса — это подразделение, о существовании которого ты можешь даже не знать, но при этом ты можешь решить любую свою аналитическую задачу и получить ответ на любой запрос.

Хороший Data Office — место, где работают профессионалы, которые понимают, что они делают, и делают это с прицелом на бизнес-результат. В том числе и проактивно предлагают бизнесу решения: не только отвечают на запросы по выручке и так далее, а сами подсказывают, какие данные нужны и как их использовать наилучшим образом.

Остались ли у вас вопросы по выстраиванию Data Office в компании? С радостью ответим на них в комментариях.

1К открытий10К показов